In quest'ultima lezione vorrei accennare ad altri tentativi di quantizzare la gravitazione. Una delle più importanti alternative alla teoria delle superstringhe e delle brane è rappresentata dalla cosiddetta Gravità Quantistica Euclidea, proposta dal famoso fisico britannico Stephen Hawking (1942-2018), noto per le sue ricerche sui buchi neri e per la sua attività di divulgatore scientifico. Il termine "euclideo" sta ad indicare che spazio e tempo sono trattati allo stesso identico modo. In pratica, l'universo non ha più tre dimensioni spaziali ed una temporale, ne ha quattro spaziali. È diventata celeberrima l'affermazione di Hawking: « Il tempo è una grandezza immaginaria », sia in senso matematico (l'unità immaginaria è la radice di – 1, una grandezza che non trova posto sulla retta reale) che nel senso posseduto da tale parola nel linguaggio corrente. Per gli abitanti di un simile universo, i concetti di "prima" e "dopo" non hanno senso, esattamente come accadeva in "Star Trek, Deep Space Nine" agli alieni che abitavano il tunnel spaziale bajoriano! Essi conoscevano il passato così come il futuro, perché le due realtà risultavano per loro coincidenti, ed è per questo che i Bajoriani li chiamavano "Profeti".

Locandina del film "La Teoria del

Tutto" (2014) del regista James

Marsh, con Eddie Redmayne nei panni del giovane Stephen Hawking

Il metodo di Hawking si basa su un principio fondamentale della meccanica quantistica, il Principio di Sovrapposizione. Ogni oggetto, classico o quantistico, si trova in uno stato, ma mentre lo stato di un oggetto classico è caratterizzato da un unico e ben definito insieme di numeri, lo stato di un oggetto quantistico è assai più difficile da formalizzare, essendo dovuto alla sovrapposizione di tutti i possibili stati in cui il sistema si può trovare. Il moto di una palla da bowling o di un pianeta attorno al Sole è descritto da un'unica precisa traiettoria, mentre di un elettrone possiamo dire solo quale probabilità ha di seguire un certo itinerario piuttosto che un altro. Ne consegue che, quando un elettrone si muove da un punto all'altro, non si muove semplicemente lungo il segmento che congiunge i due punti, ma lungo tutti i possibili percorsi simultaneamente. La traiettoria "effettiva" dell'elettrone risulterà da una media ponderata di tutte le possibilità. Seguendo questo metodo, si può calcolare la probabilità di trovare l'elettrone in un qualsiasi intervallo di posizioni e di velocità. La Gravità Quantistica Euclidea applica il principio di sovrapposizione all'intero Universo: i diversi stati possibili su cui si esegue la media ponderata in questo caso sono tutti i diversi modi in cui l'universo potrebbe evolvere nel tempo e su larga scala, e quindi tutte le possibili geometrie dello spazio-tempo.

Dato che già lo studio delle varietà di Riemann appare difficilissimo, possiamo immaginare quanto lo sia sovrapporre tutte le varietà di Riemann possibili, ciascuna descritta da un complicatissimo Tensore di Ricci, Il metodo di Hawking è però diventato agevolmente applicabile dopo l'introduzione di potenti computer in grado di effettuare in un tempo relativamente breve una mole colossale di calcoli. A questo scopo, le geometrie riemanniane curve vengono sostituite con strutture approssimare composte da triangoli uniti l'un l'altro lungo i lati; tali triangoli vengono detti simplessi. Queste strutture composte da triangoli, simili per certi versi alle strutture realizzate con il gioco del geomag, possono essere trattate in modo agevole dai supercomputer; ovviamente le complesse strutture quadridimensionali dello spazio-tempo saranno realizzate con tetraedri tridimensionali, ma il principio non cambia.

Naturalmente i simplessi, triangolari o tetraedrici che siano, in realtà non esistono, trattandosi di una mera modellizzazione geometrica; attraverso di essi è però possibile studiarne il comportamento collettivo, tenendo conto che, se il loro numero tendesse all'infinito e le loro dimensioni a zero, staremmo descrivendo con precisione assoluta la varietà di Riemann in questione. L'indipendenza del comportamento globale da ciò che accade a piccola scala è detto « universalità », un concetto basilare nella Fisica Statistica. Solo un genio come il compianto Stephen Hawking poteva elaborare un calcolo talmente complesso per le menti di noi, comuni mortali! A questo proposito, mi si permetta un omaggio al grande Fisico britannico scomparso il 14 marzo 2018. sul n° 3175 di "Topolino" del 28 Settembre 2016 è stata pubblicata l'avventura a fumetti "Topolino e l'esperimento del Dottor Pi", nel quale vediamo sfilare una straordinaria galleria di Fisici che hanno partecipato alla Conferenza Solvay del 1927, disegnati da Alessandro Perina con la consulenza del noto Fisico Carlo Rovelli (1956-), autore del best seller "Sette brevi lezioni di fisica" (2014). Tra di essi Topolino e Pippo non possono fare a meno di incontrare il grande Albert Einstein. Come ha suggerito Gianluigi Filippelli in questa pagina, in una vignetta appare un anonimo fan che promette di conservare come un tesoro l'autografo di Einstein: anche se nel 1927 non era ancora nato, a noi non può non far pensare ad un giovane Stephen Hawking!

Stephen Hawking e Albert Einstein?

Purtroppo, però, la Gravità Quantistica Euclidea non ha fornito risultati soddisfacenti: ben presto ci si è accorti infatti che gli universi costruiti con le simulazioni informatiche risultavano intrinsecamente instabili. Le fluttuazioni quantistiche su piccola scala della curvatura, caratteristica dei vari universi su cui si esegue la media ponderata, non si eliminavano affatto a vicenda per produrre l'universo classico, che è uniforme su larga scala; anzi, si sommavano rafforzandosi reciprocamente, facendo sì che l'universo si "accartocciasse" in una minuscola palla con un numero infinito di dimensioni, oppure desse vita a strane forme esotiche, certamente molto lontane dall'immagine che noi abbiamo del nostro cosmo.

Come uscire da questa impasse? Nel 1998 Jan Ambjørn (1951-) del Niels Bohr Institute di Copenhagen, Jerzy Jurkiewicz dell'Università Jagellonica di Cracovia e Renate Loll (1962-) dell'Università di Utrecht tentarono un approccio differente, da loro definito Triangolazione Dinamica Causale, partendo da uno dei punti deboli della teoria di Hawking e soci. La Gravità Quantistica Euclidea è difatti priva della nozione di causalità, perché non ha una nozione di tempo distinta dallo spazio, e quindi è impossibile disporre gli eventi in ordine cronologico. Hawking e collaboratori speravano che la causalità emergesse su larga scala a partire da fluttuazioni quantistiche microscopiche le quali, individualmente, non danno vita ad alcuna relazione causale. Le simulazioni al computer hanno però deluso questa speranza.

E così, invece di ignorare la causalità, Ambjørn, Jurckiewicz e Loll hanno deciso di incorporarla in uno stadio molto precedente. Ad ogni simplesso hanno assegnato una freccia del tempo dal passato al futuro, quindi hanno stabilito che due simplessi possano essere uniti tra loro solamente se le rispettive frecce del tempo puntano nella stessa direzione. In pratica, essi devono condividere una nozione di tempo che non si fermi mai e non torni mai indietro. Lo spazio mantiene la sua forma complessiva man mano che il tempo avanza, e non può frammentarsi in parti discontinue né creare i famosi tunnel spaziali come quello di Bajor. Stavolta le simulazioni al computer hanno dato loro ragione: su larga scala, l'universo così ottenuto ha proprio quattro dimensioni! La stabilità di questo universo richiede l'introduzione di una costante cosmologica, e ciò è in accordo con le osservazioni che confermano l'esistenza dell'energia oscura. Lo spazio-tempo da loro generato segue inoltre la Geometria di de Sitter, che è la soluzione delle equazioni di Einstein in un universo dotato di costante cosmologica.

Una delle novità più dirompenti di questo approccio consiste nel fatto che il numero di dimensioni dipende dalla scala a cui si osserva lo spazio-tempo! In altre parole, le simulazioni di breve durata dell'universo sembrano avere un numero di dimensioni diverso dalle simulazioni più lunghe. La cosa appare davvero stupefacente e contraria al senso comune, eppure non è del tutto esotica. Fino alla Lunghezza di Planck (8.2), per l'universo vale la classica Geometria di de Sitter a quattro dimensioni. Alla scala di Planck, invece, le fluttuazioni quantistiche diventano così forti, da compromettere la stessa nozione intuitiva di Geometria; il numero di dimensioni, dal valore classico di quattro, precipita a circa due. Tuttavia, lo spazio-tempo così ottenuto è ancora continuo ed è privo di tunnel spaziali che lo farebbero assomigliare ad una schiuma turbolenta. La sua geometria obbedisce a regole diverse da quelle classiche, ma il concetto di distanza si applica comunque. Una possibilità è che l'universo abbia una struttura frattale: un frattale è una struttura autosimile, che cioè ha lo stesso aspetto a tutte le scale a cui la si guarda. L'aggettivo auto simile, applicato al nostro universo, ci dice che esso avrà lo stesso aspetto a tutte le scale sotto una certa soglia: in questo caso, lo spazio-tempo non sarebbe fatto né di stringhe né tanto meno di atomi di spazio e tempo, ma sarebbe una regione di ripetitività infinita: la struttura osservata appena al di sotto della soglia semplicemente ripeterebbe se stessa ad ogni scala più piccola, fino all'infinito! Si parla per questo di cosmologia frattale.

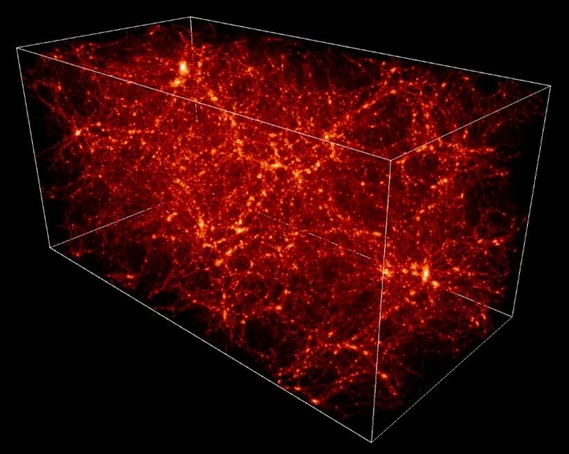

In ogni caso, l'analisi statistica delle strutture dell'Universo a grande scala evidenzia il fatto che la distribuzione delle galassie non è regolare ma presenta grandi ammassi e regioni quasi vuote su scale dell'ordine del miliardo di anni luce: una distribuzione che mostra ben definite proprietà frattali, le quali si estendono fino ai limiti delle osservazioni telescopiche. Qui sotto potete vedere la distribuzione delle galassie e della materia oscura ottenuta dal Canada–France–Hawaii Telescope (CFHT) posto sulla sommità del Mauna Kea, il più grande vulcano delle Hawaii (da questo sito): l'aspetto di questa distribuzione è decisamente frattale. Il fisico italiano Fausto Bersani Greggio a questo proposito ha calcolato la dimensione frattale media della mappa della radiazione di fondo realizzata dal satellite Planck, ottenendo un valore pari a 1,20 ± 0,08, in linea con le osservazioni che prevedono, per la distribuzione delle galassie e dei relativi ammassi, una dimensione frattale proprio pari all'incirca a 1,2: un risultato estremamente incoraggiante, ma non definitivo. Invece Morag Scrimgeour, giovane dottoranda australiana, usando la Survey WiggleZ, un catalogo di oltre 200.00 galassie in un volume totale di circa tre miliardi di anni luce cubi, sostiene che la struttura frattale scompare al di sopra di una dimensione tipica di 350 milioni di anni luce, limite sopra il quale l'omogeneità prevista dal Principio Cosmologico annullerebbe qualsiasi struttura nell'indistinta uniformità del tutto.

In alternativa all'universo frattale, vorrei citare una nuova, suggestiva teoria che promette di risolvere l'essenziale incompatibilità tra meccanica quantistica e relatività generale attribuendo al tessuto dello spazio-tempo le proprietà di un fluido con una viscosità bassissima, cioè di un superfluido. Come abbiamo visto, già la Gravità Quantistica a Loop pensa allo spazio-tempo come una complessa sostanza costituita nel suo intimo da elementi più piccoli, da "atomi" di spazio-tempo se così si può dire. In questo caso, le proprietà dello spazio-tempo dovrebbero "emergere" dalla fisica di base dei suoi costituenti, proprio come le proprietà dell'acqua derivano dalla fisica che governa le particelle che la compongono. « L'acqua è fatta di singole molecole che interagiscono tra loro secondo le leggi della meccanica quantistica; ma l'acqua liquida appare un continuo, fluido, trasparente e rifrangente », ha spiegato Ted Jacobson (1954-) dell'Università del Maryland a College Park. « Queste sono tutte proprietà che non possono essere trovate nelle singole molecole, anche se, in ultima analisi, derivano da esse ». Per sapere se davvero lo spazio-tempo ha le caratteristiche tipiche di un fluido come l'acqua, occorre naturalmente confrontare le osservazioni astrofisiche con le previsioni basate su tale modello; ma non è facile ottenere risultati significativi, perché uno spazio-tempo di tipo fluido non sarebbe immediatamente distinguibile dalla spazio-tempo di un'altra teoria quantistica della gravità.

A questo proposito Stefano Liberati (1970-) della Scuola Internazionale Superiore di Studi Avanzati (SISSA) di Trieste e Luca Maccione della Ludwig-Maximilians-Universität di Monaco di Baviera hanno studiato in che modo questa struttura ideale possa influenzare la luce che viaggia attraverso l'universo, e si sono concentrati su situazioni estreme, che coinvolgono fotoni molto energetici. Essi potrebbero viaggiare attraverso lo spazio-tempo come le onde in un oceano, e si potrebbero applicare le leggi della meccanica dei fluidi e della fisica della materia condensata. In precedenza altri fisici hanno considerato in che modo come particelle di diverse energie verrebbero disperse nello spazio-tempo, proprio come le onde di diverse lunghezze d'onda si disperdono, o si propagano a velocità diverse, nell'acqua. In quest'ultimo studio invece Liberati e Maccione hanno preso in considerazione un altro fenomeno tipico dei fluidi: la dissipazione. Come le onde che si propagano in un mezzo, anche le particelle perdono energia nel tempo, e questo effetto frenante potrebbe riguardare anche i fotoni che viaggiano attraverso lo spazio-tempo. Anche se l'effetto è piccolo, fotoni molto energetici che viaggiano su enormi distanze dovrebbero perdere una notevole quantità di energia. I due studiosi in particolare hanno preso in considerazione la Nebulosa del Granchio, il residuo di una supernova esplosa nel 1054 d.C. che dista circa 6.500 anni luce dalla Terra e che emette raggi X ad alta energia e raggi gamma. Con il passare tempo, questa luce raggiunge i nostri telescopi: la sua energia dovrebbe essersi dissipata in qualche misura se lo spazio-tempo ha effettivamente le proprietà di un liquido. Le osservazioni invece non mostrano alcun segno di tale fenomeno. « Nel nostro studio mostriamo che lo spettro di radiazione sarebbe notevolmente influenzato da questa perdita di energia perché viaggia per molto tempo, anche se si tratta di un effetto molto limitato », ha sottolineato Stefano Liberati. La mancanza di effetti di dissipazione ha permesso di porre forti vincoli sugli effetti liquidi che potrebbero essere presenti nello spazio-tempo, mostrando che essi devono essere estremamente piccoli o del tutto assenti, restringendo le possibilità di uno spazio-tempo fluido a liquidi con viscosità molto basse, che quasi non bagnano le superfici: i superfluidi, per l'appunto. Se è vero che i fotoni di energie differenti viaggiano a velocità diverse e dissipano energia col passare del tempo, allora la Relatività non può valere in tutte le situazioni. Uno dei fondamentali principi della Teoria della Relatività Ristretta afferma che la velocità della luce è una constante universale, indipendente dal moto del sistema di riferimento in cui si trova l'osservatore. « L'idea che lo spazio-tempo come noi lo conosciamo emerga da qualcosa che viola la relatività è piuttosto radicale », ha ammesso Jacobson. Quest'ultimo e molti altri suoi colleghi tuttavia continuano a battere questa strada, poiché essa consentirebbe in linea di principio di risolvere alcuni dei problemi di incompatibilità tra la relatività generale e la meccanica quantistica. In ogni caso, se lo spazio-tempo è davvero un superfluido, i fisici teorici sono attesi da una difficilissima navigazione su di esso.

Degno di nota è anche il cosiddetto "procedimento della doppia copia". I fisici Zvi Bern dell'Università della California a Los Angeles, Lance Dixon dello SLAC, John Joseph Carrasco della Northwestern University e Henrik Johansson dell'Università di Uppsala, lo hanno sviluppato negli anni duemiladieci, rielaborando un aspetto della teoria delle stringhe. Nella somma di tutte le possibili interazioni che potrebbero avvenire durante un evento dovuto alla forza forte, il termine matematico che rappresenta ogni interazione si divide in due parti, proprio come il numero 15 si può scomporre in 3 × 5. La prima parte coglie la "natura" della forza in questione, cioè la proprietà chiamata colore. Il secondo termine esprime il movimento delle particelle, ovvero la loro "cinematica". Per eseguire la doppia copia, si elimina il termine di colore e lo si sostituisce con una copia del termine di cinematica, trasformando 3 × 5 in 5 × 5. Se 15 descrive il risultato di un evento di forza forte, allora la doppia copia ci dice che 5 x 5 = 25 corrisponderà a qualche evento gravitazionale ad esso comparabile. La doppia copia ha però un tallone d'Achille: prima di eseguire la procedura, i fisici teorici devono riscrivere il termine di cinematica in una forma che somigli al termine di colore. Questa riformattazione è difficile e potrebbe non essere sempre possibile via via che il calcolo viene perfezionato per includere interazioni sempre più complesse. Ma se si riesce a portarlo a termine, allora la gravità viene fuori in modo naturale. Questo procedimento purtroppo non ha molto senso fisico, poiché a rigore i gravitoni non sono coppie di gluoni, ma fornisce una potente scorciatoia matematica. Bern, Carrasco e altri loro colleghi hanno trascorso anni a lavorare su una teoria esotica chiamata supergravità, che bilancia i gravitoni con le particelle partner in modo matematicamente accettabile. Usando il procedimento della doppia copia, hanno completato calcoli di supergravità sempre più precisi. Anche se la supergravità è troppo simmetrica per riflettere il nostro mondo, la sua semplicità la rende l’opzione più alla portata tra le possibili teorie particellari della gravità. Bern e colleghi sperano di estendere i loro successi computazionali a teorie più realistiche, come ad esempio lo studio dei buchi neri rotanti o quello delle onde gravitazionali. I ricercatori notano che l'elettromagnetismo, la forza debole e la forza forte seguono un tipo specifico di simmetria; ebbene, quando viene riscritta con la doppia copia, la gravità sembra obbedire a una simmetria simile a quella delle tre forze quantistiche. È come se ci fosse una "quarta simmetria madre", una simmetria alla base di tutto. Ci vorrà tempo per capire se questo procedimento a prima vista senza senso resterà un artificio matematico o permetterà di effettuare davvero grandi scoperte.

Altre teorie più o meno stravaganti per quantizzare la gravitazione sono la Teoria dei Torsori, proposta nel 1967 da Roger Penrose e successivamente integrata in una variante della Teoria delle Superstringhe, e la Gravità Indotta del famoso fisico e dissidente russo Andrei Sakharov (1921–1989), basata sull'analogia tra alcuni aspetti della Relatività Generale e il comportamento di certi cristalli. Tutte queste innumerevoli proposte per giungere ad una quantizzazione della gravitazione soffrono però di un grave difetto, lo stesso che ha messo in crisi le superstringhe e la M-teoria: gli effetti da esse previsti sono in genere troppo piccoli per poter essere sottoposti a verifica sperimentale. I Fisici tuttavia sperano che i nuovi telescopi orbitanti come il James Webb Space Telescope e i progetti in corso per l'astrofisica ad onde gravitazionali ci offrano un giorno le risposte che cerchiamo, e ci aiutino a conquistare quel Santo Graal della Fisica Moderna che è l'unificazione definitive di tutte le forze della Natura.

Prima di chiudere, vorrei fare un cenno alle ipotesi dell'informatico e fisico statunitense Edward Fredkin (1934-2023), famoso e molto discusso per aver proposto che le leggi della fisica siano il risultato nientemeno che... di un algoritmo informatico, tanto che egli si spinse a parlare addirittura di "fisica digitale": una teoria considerata da principio completamente folle (nessuno scienziato degno di questo nome avrebbe mai accettato che la scienza della computazione potesse insegnare qualcosa sulla fisica), ma oggi assai rivalutata. Fredkin, professore ordinario al Massachusetts Institute of Technology (MIT) e fondatore della Information International, specializzata in hardware e programmi di imaging, fu tra i primi ad occuparsi di intelligenza artificiale (AI). Alla fine degli anni sessanta quest'ultima era ancora un concetto poco più che fantascientifico, ma Fredkin fuil primo a cogliere le sfide politiche che le macchine in grado di apprendere e prendere decisioni autonome ponevano, anche per la sicurezza nazionale. Egli sostenne la collaborazione internazionale nella ricerca sull'AI, tuttavia i suoi tentativi di convocare una riunione internazionale dei migliori pensatori del settore non si sono mai concretizzati, di fatto rallentando di molto il suo sviluppo. Si occupò anche di computazione reversibile, all'epoca considerata impossibile. Un computer digitale convenzionale è composto infatti da una serie di porte logiche (AND, OR, XOR e così via) in cui, generalmente, due ingressi diventano un'uscita. Le informazioni in ingresso sono cancellate, trasformandosi in calore, e il processo non può essere invertito. Insieme a Norman Margolus (1955-) e a un giovane ingegnere elettrotecnico italiano, Tommaso Toffoli (1943-), Fredkin dimostrò che alcune porte con tre ingressi e tre uscite potevano essere disposte in modo da preservare tutte le fasi intermedie di ogni possibile calcolo, consentendo di invertire il processo al termine. Come hanno spiegato in un articolo fondamentale del 1982, un computer costruito con queste porte potrebbe, almeno in teoria, non produrre calore di scarto e quindi non consumare energia.

Edward Fredkin (1934-2023)

Inizialmente questa sembrava solo una curiosità: Fredkin riteneva che il concetto avrebbe potuto contribuire allo sviluppo di computer più efficienti e con meno sprechi di calore, ma non esisteva un modo pratico per realizzare pienamente l'idea usando i computer classici. Nel 1981, tuttavia, Fredkin e Toffoli organizzarono il Physics of Computation Symposium al MIT, alla presenza tra gli altri del grande Richard P. Feynman, e lì Fredkin suggerì che, invece di cercare di simulare i fenomeni quantistici con i computer digitali convenzionali, alcuni sistemi fisici che mostrano un comportamento quantistico potrebbero essere strumenti migliori. Questo contributo è oggi considerato l'inizio dell'era dei computer quantistici, che sfruttano tutta la potenza della meccanica quantistica per risolvere i problemi molto più velocemente di qualsiasi computer classico. Oggi alcuni piccoli computer quantistici sono già in fase di sviluppo. L'elettronica, i laser e i sistemi di raffreddamento necessari per farli funzionare consumano molta energia, ma le operazioni logiche quantistiche sono praticamente prive di perdite. « La computazione reversibile era una precondizione essenziale per poter concepire i computer quantistici », ha affermato Seth Lloyd, ingegnere meccanico del MIT che nel 1993 ha sviluppato quello che è considerato il primo concetto realizzabile di computer quantistico. Nel loro articolo del 1982, Fredkin e Toffoli avevano iniziato a sviluppare il loro lavoro sulla computazione reversibile a partire da un'analogia con un tavolo da biliardo, dimostrando come le computazioni matematiche potessero essere rappresentate da interazioni biliardo-palla completamente reversibili, ipotizzando un tavolo senza attrito e palle che interagiscono senza attrito. Toffoli pensava che i concetti computazionali potessero essere un modo migliore per sintetizzare la fisica rispetto alle equazioni differenziali convenzionalmente usate per descrivere il movimento e il cambiamento, ma Fredkin si spinse oltre, concludendo nientemeno che l'intero universo potrebbe essere visto come una sorta di colossale computer! A suo avviso si tratterebbe di un "automa cellulare": un insieme di bit computazionali, o cellule, che possono cambiare stato in base a un insieme definito di regole determinate dagli stati delle cellule che le circondano. Nel tempo, queste semplici regole possono dare origine a tutte le complessità che osserviamo nel cosmo, fino alla vita e all'autocoscienza di sé. E non era neanche la prima volta che una simile, stravagante ipotesi veniva formulata: Konrad Zuse (1910-1995), un ingegnere civile tedesco che prima della seconda guerra mondiale sviluppò uno dei primi computer programmabili, nel 1969 aveva già suggerito nel suo saggio "Calculating Space" che l'universo potesse essere visto come un classico automa cellulare digitale.

Naturalmente la prima visione incontrò più oppositori che sostenitori: il fisico Philip Morrison (1915-2005), allora anche lui in forza al MIT, affermò con acre sarcasmo che Fredkin era un informatico, e quindi pensava che l'universo fosse un grande computer, ma se fosse stato un commerciante di formaggi, avrebbe pensato che l'universo fosse un grande formaggio. Tra i sostenitori si annoverano invece l'informatico britannico Stephen Wolfram (1959-), esperto di teoria della complessità, che nel 2002 ha proposto idee simili nel suo saggio "A New Kind of Science", ma anche il premio Nobel per la fisica olandese Gerard 't Hooft (1946-) e il fisico statunitense John Archibald Wheeler (1911-2088), che ha riassunto tutta la "fisica digitale" nel suo famoso motto « it from bit ». Oggi si è arrivati a parlare di "filosofia digitale", e addirittura di "pancomputazionalismo" e di "digitalismo". Alcuni, tuttavia, hanno concluso che un modello computazionale classico non può essere responsabile della complessità quantistica dell'universo che osserviamo, come l'entanglement tra due stati quantistici separati nello spazio. Secondo Seth Lloyd (1960), anch'egli al MIT, la teoria dell'universo digitale originale di Fredkin « presenta problemi molto seri affinché un universo digitale classico sia in grado di comprendere i fenomeni della meccanica quantistica »; ma se si scambiano le regole di calcolo classiche della fisica digitale di Fredkin con regole quantistiche, molti di questi problemi si risolvono. Seth Lloyd ha esposto questa idea nel 2006 nel suo saggio "Programming the Universe", in cui spiega come le regole della computazione quantistica potrebbero spiegare le leggi fisiche conosciute, cioè le particelle elementari, il Modello Standard e forse addirittura la tanto sospirata teoria quantistica della gravità!

Si badi bene: queste proposte sono molto diverse dall'idea più recente che viviamo in una simulazione al computer, avanzata tra gli altri dal filosofo svedese Nick Bostrom (1973-) dell'Università di Oxford, che ha ispirato tra l'altro la fortunata saga di "Matrix". Mentre l'universo digitale presuppone che le condizioni iniziali e le regole di base dell'universo computazionale siano sorte naturalmente, proprio come le particelle e le forze della fisica sono sorte naturalmente nel Big Bang e nelle sue conseguenze, l'ipotesi della simulazione presuppone che l'universo sia stato costruito deliberatamente da programmatori alieni intelligenti e altamente avanzati, come una sorta di grande esperimento o addirittura di gioco: uno sforzo poco plausibile secondo Lloyd (e secondo me).

L'idea di base di un universo digitale potrebbe essere verificabile sperimentalmente: come si è visto, affinché il cosmo sia stato prodotto da un sistema di bit di dati alla minuscola scala di Planck, lo spazio e il tempo devono essere costituiti da entità discrete e quantizzate. L'effetto di uno spazio-tempo così granulare potrebbe manifestarsi in minuscole differenze, per esempio, nel tempo che la luce di varie frequenze impiega a propagarsi attraverso miliardi di anni luce. Tuttavia, per poter confermare davvero l'idea, e ci troviamo sempre a girare in tondo nel bosco, sarebbe necessaria una teoria quantistica della gravità che stabilisca la relazione tra gli effetti della teoria generale della relatività di Einstein sulla macroscala e gli effetti quantistici sulla microscala: proprio ciò che finora è sfuggito ai fisici teorici. Secondo Lloyd, però, i percorsi favoriti verso le teorie quantistiche della gravitazione iniziano gradualmente a sembrare di natura sempre più computazionale, per esempio il principio olografico introdotto da 't Hooft, secondo il quale il nostro universo è una proiezione di una realtà di dimensioni inferiori: le idee di base dell'universo digitale quantistico potrebbero far luce su alcuni di questi misteri. Non ci resta che metterci al lavoro e cercare di dimostrarlo!

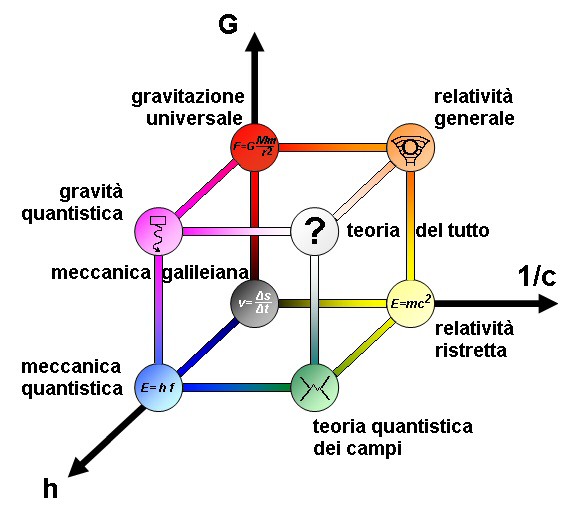

Come si vede, la Fisica di Domani ha davanti a sé un numero impressionante di vie da battere per aiutarci a comprendere meglio gli inestricabili misteri con i quali il cosmo ci interroga continuamente. È possibile trovare un ordine in questo guazzabuglio? Non ci crederete, ma la risposta è positiva. Ora vi mostrerò come rappresentare tutte le teorie della Fisica da noi analizzate su di un unico grafico, chiamato "cubo delle teorie", che vedete disegnato qui sotto da me (questo è uno dei siti da cui ho preso ispirazione). Esso fu concepito dai fisici russi Matvej Petrovič Bronštejn (1906-1938, vittima delle purghe staliniane), Efim Isaakovič Zelmanov (1955-) dell'Università della California a San Diego, e Lev Borisovič Okun' (1929-2015) dell'Istituto per la Fisica Teorica e Sperimentale di Mosca.; infatti, dalle loro iniziali viene chiamato anche "cubo ZBO".

Il Cubo delle Teorie

Come si vede, sui tre assi cartesiani sono state riportate le tre costanti fondamentali della Fisica: l'inverso 1 / c della velocità della luce c, alla base della Relatività Ristretta di Albert Einstein; la costante di Planck h, il fondamento della Meccanica Quantistica; e la costante di Gravitazione Universale G, caratteristica della Gravitazione Universale di Isaac Newton. Se 1 / c, h e G valgono tutte zero, abbiamo una teoria che non è né relativistica, né quantistica, e non descrive fenomeni gravitazionali. Dire infatti che 1 / c tende a zero significa affermare che la velocità della lice tende all'infinito, e quando siamo lontanissimi da c non si manifestano fenomeni relativistici; dire che h tende a zero significa che siamo su una scala di gran lunga superiore a quella atomica, e dunque non si manifestano fenomeni quantistici; se G è trascurabile, anche l'attrazione gravitazionale tra i singoli corpi è trascurabile. L'origine degli assi rappresenta dunque la semplice Meccanica Galileiana. Tutti gli altri vertici del cubo di lato unitario che vediamo riprodotto qui sopra rappresentano altrettante teorie fisiche:

1) il vertice ( 0 ; 0; G ) rappresenta una teoria non relativistica e non quantistica che si occupa delle interazioni gravitazionali. Essa è quindi la Gravitazione Universale, messa a punto da Isaac Newton nel 1687. Potete saperne di più in quest'altro mio ipertesto. L'ho rappresentata con una sfera rossa.

2) il vertice ( 1 / c ; 0 ; 0 ) rappresenta una teoria non quantistica e non gravitazionale ma relativistica: è dunque la Relatività Ristretta di Albert Einstein, messa a punto nel 1905. Potete trovarla sintetizzata in questo lavoro. L'ho rappresentata con una sfera gialla.

3) il vertice ( 0; h ; 0 ) rappresenta una teoria non relativistica e non gravitazionale ma quantistica: è la Meccanica Quantistica, avviata nel 1900 da Max Planck e poi messa a punto a fine anni Venti da Werner Heisenberg, Erwin Schrödinger e Paul Dirac. L'ho rappresentata con una sfera azzurra.

4) il vertice ( 1 / c ; 0 ; G ) rappresenta invece una teoria gravitazionale e relativistica, ma non quantistica: è la Relatività Generale, avviata da Albert Einstein nel 1916 con il suo lavoro "Die Grundlage der allgemeinen Relativitätstheorie" ("Fondamenti di Relatività Generale"). Potete trovarne un sunto in questa pagina. Dato che "mescola" relatività e gravitazione, l'ho indicata con una sfera arancione (giallo + rosso).

5) il vertice ( 1 / c ; h ; 0 ) rappresenta una teoria quantistica e relativistica, ma non gravitazionale. Si tratta della Teoria Quantistica dei Campi, che interpreta tutti i campi di forze attraverso lo scambio di "particelle virtuali"; ne abbiamo parlato in questa lezione. Dato che "mixa" relatività e quanti, l'ho rappresentata con una sfera verde (giallo + azzurro).

6) il vertice ( 0; h ; G ) rappresenta una teoria non relativistica, ma tale da unificare quanti e gravitazione: insomma, una Teoria della Gravità Quantistica, della quale abbiamo ampiamente parlato nelle ultime lezioni. In attesa che questo problema possa trovare una soluzione definitiva, io l'ho rappresentata come una sfera magenta (azzurro + rosso).

7) infine, manca solo il vertice ( 1 / c ; h ; G ), cioè una teoria che tenga conto ad un tempo di relatività, quanti e gravitazione. Una teoria del genere sarebbe in grado di interpretare con precisione qualunque fenomeno naturale, anche il più bizzarro, e conterrebbe tutte le altre suddette teorie come casi particolari. Sarebbe insomma una Teoria del Tutto., il sogno recondito e inconfessabile di ogni appassionato di Fisica, e quindi anche del sottoscritto Non a caso, io la ho rappresentata con una sfera bianca, perchè il bianco è la sovrapposizione di tutti gli altri colori!

Ci sarebbero infinite altre cose da dire sulle Frontiere della Fisica, ma dopo questa sintesi così completa, io preferisco fermarmi qui. Aggiungerò solo una cronologia essenziale della Fisica Moderna, così da darvi un quadro storico d'insieme della genialità degli uomini di scienza vissuti nell'ultimo secolo e mezzo. Grazie a voi per avermi seguiti fin qui; vi lascio con questo invito di Albert Einstein, sempre attuale come la maggior parte dei suoi aforismi: « La logica vi porterà da A a B. L'immaginazione vi porterà dappertutto! »

Buona scienza a tutti.