![]()

|

"Nel principio Eru, l'Uno, creò gli Ainur; e gli Ainur intonarono una Grande Musica al suo cospetto. Da tale Musica, il mondo ebbe inizio..." J.R.R. Tolkien, "Il Silmarillion" |

.

8.1 La grande unificazione delle forze

Nel corso del nostro ipertesto abbiamo visto come lo sviluppo storico della teoria della gravitazione, e della Fisica in genere, corrisponda ad un tentativo di unificare ambiti molto diversi della storia naturale:

1) Galilei,

Kepler e Newton

hanno unificato la meccanica terrestre con la meccanica

celeste (§ 1.4)

2) Maxwell ha unificato i fenomeni elettrici,

quelli magnetici e l'ottica

(vedi altro

ipertesto)

3) Einstein ha unificato la teoria

gravitazionale con l'analisi della geometria

dello spazio-tempo (§ 6.8)

Come naturale conseguenza di questa logica di sintesi, Einstein si domandò: se la Relatività Generale é applicabile così bene ai campi gravitazionali, tanto da poter spiegare fenomeni senza plausibile interpretazione come la precessione del perielio di Mercurio o le lenti gravitazionali, perché non lo é anche a quelli elettromagnetici o nucleari? In altre parole, é possibile mettere in relazione gli effetti di un'accelerazione su di un sistema con quelli di un campo di natura diversa da quello di gravità? Einstein dedicò gli ultimi quarant'anni di vita alla soluzione di questo problema, ma senza ottenere risultati soddisfacenti.

Si tratta in effetti di un problema noto alla Fisica Moderna come problema della grande unificazione delle forze. Le quattro forze della natura (elettromagnetica, gravitazionale, nucleare debole, nucleare forte) erano in origine considerati tipi differenti di interazione, senza alcuna possibile causa o meccanismo comune, un po' come prima di Darwin le specie viventi erano considerate come atti separati della Creazione Divina, né si pensava che la loro origine potesse essere la medesima. I Fisici della seconda metà del secolo XX cominciarono invece ad intuire che le quattro interazioni potrebbero essere aspetti diversi di un'unica forza originaria, i cui effetti sono diversi a seconda del tipo di oggetto tra cui interagisce: le masse per la forza di gravità, le cariche elettriche per la forza elettromagnetica, le cariche barioniche per la forza nucleare forte, le particelle dotate di "stranezza" per la forza nucleare debole (carica elettrica, carica barionica e stranezza sono proprietà intrinseche delle particelle elementari).

Dopo il lavoro teorico di Steven Weinberg (1933–) ed Abdus Salam (1926–1996) e le conferme sperimentali ad opera di Carlo Rubbia (1934–), questa teoria ha avuto una prima conferma con l'unificazione delle forze elettromagnetica e debole nell'unico campo "elettrodebole", scoperta per la quale Weinberg e Salam vinsero il Nobel nel 1979, e Rubbia nel 1984. Non hanno invece ancora avuto conferma sperimentale cosiddette Teorie di Grande Unificazione (GUT), che dovrebbero permettere di unificare anche la forza nucleare forte alle due precedenti. Come abbiamo già accennato parlando del Big Bang (§ 7.5), si pensa che tutte queste forze appaiano di natura diversa in seguito a successive rotture di simmetria avvenute quando l'universo era ancora in fasce: inizialmente esisteva effettivamente un'unica interazione fondamentale ma, man mano che la temperatura scendeva, esse si separarono progressivamente l'una dall'altra, come le vediamo oggi. Se si riuscisse a ripristinare le condizioni iniziali che hanno dato origine all'universo, probabilmente sparirebbe ogni differenza fra le dette forze.

Il problema principale che si para tra noi e questo obiettivo è puramente energetico: quando le forze erano unificate e l'universo simmetrico, il cosmo era anche caldissimo e densissimo. In pratica, man mano che aumenta l'energia in gioco, le forze tendono a confluire le une nelle altre. Per dimostrare l'esistenza delle particelle W+, W– e Z0 che mediano l'interazione elettrodebole, Rubbia ha dovuto servirsi di acceleratori in grado di fornire alle particelle l'energia di ben 100 GigaelettronVolt, al limite della portata dei nostri impianti più potenti. Per unificare ad esse anche la forza nucleare forte, sarebbe necessaria un'energia di addirittura 1015 GigaelettronVolt, che nessun acceleratore potrebbe mai raggiungere: si tratta di un valore di mille miliardi di volte maggiore di quello ottenibile con l'LHC di Ginevra, e per raggiungerlo occorrerebbe un acceleratore di dimensioni paragonabili a quelle della nostra galassia!.

Nella "TEORIA DEL TUTTO" inseguita pervicacemente da Einstein, ad energie elevatissime, che come vedremo sono superiori ai 1019 GeV, anche la forza gravitazionale, che peraltro è la più debole di tutte, dovrebbe confluire nelle altre, trasformandosi in un caso speciale dell'unica superforza originale. Poiché una verifica sperimentale di questa ipotetica teoria è assolutamente al di fuori della nostra portata, l'unica possibilità consiste nel cercare delle prove indirette. Ad esempio, le GUT potrebbero prevedere tra l'altro il decadimento del protone, e sono oltre trent'anni che i fisici sono alla caccia di un protone che decade. Ebbene, se fosse possibile coinvolgere in un'unica teoria la forma dello spazio-tempo, l'elettromagnetismo e le forze nucleari, una delle conseguenze indirette di tale teoria sarebbe l'esistenza delle onde gravitazionali.

.

8.2 Onde nello spazio-tempo

Sappiamo bene che i campi elettromagnetici non si trasmettono istantaneamente, bensì tramite onde; e i campi gravitazionali? Si trasmettono istantaneamente oppure no? Dall'analisi delle Equazioni Gravitazionali di Einstein (7.10) è possibile ricavare che anche i parametri geometrici dello spazio-tempo (il Tensore di Ricci e la sua traccia) obbediscono ad un'equazione differenziale alle derivate parziali nota come Equazione di d'Alembert, cui fanno capo tutti i fenomeni ondulatori. Essa trae il nome da Jean-Baptiste d'Alembert (1717–1783), ed è molto complicata, per cui non la riporto in questa sede; basti dire che, obbedendo a tale equazione, anche i campi gravitazionali devono necessariamente propagarsi per onde.

Ciò significa che, se il Sole sparisse all'istante come per magia, la Terra non proseguirebbe immediatamente lungo la tangente alla propria orbita, ma continuerebbe a ruotare intorno al vuoto ancora per otto minuti, il tempo impiegato dalla luce a coprire la distanza Terra-Sole, dato che, secondo la Relatività Ristretta, un'onda non può in alcun modo superare la velocità della luce. Ma, se ciò vi sembra sorprendente, c'è anche dell'altro. Infatti le onde gravitazionali non si propagano in un mezzo materiale, come i suoni o le onde sismiche, ma nella struttura geometrica stessa dello spazio-tempo, modificandone la metrica (7.7). In altre parole, il passaggio di un'onda gravitazionale modificherebbe la distanza di due punti, sia nello spazio che nel tempo, facendo tremolare ogni cosa investita da essa. Ma non sarebbero gli oggetti in sé a tremolare, come le pareti di una casa squassata da un terremoto, bensì la stessa tessitura del cronotopo, esattamente come la massa deforma la geometria stessa dell'universo, e quindi le sue geodetiche! In pratica, in seguito al passaggio di un'onda gravitazionale, le geodetiche da rette si trasformano in... sinusoidi!

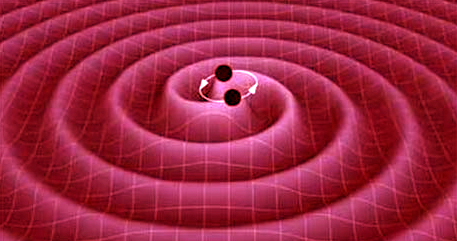

Onde

gravitazionali generate da due pulsar

in rapida rotazione l'una rispetto all'altra

Siccome l'esperienza concettuale del Sole che scompare dal nostro sistema non è ovviamente realizzabile, anche delle onde gravitazionali dobbiamo cercare delle prove indirette. Oggi il modello teorico più accreditato prevede che l'intensità della radiazione gravitazionale emessa da un corpo dipenda dal grado di disomogeneità nella distribuzione della sua massa, cioè dalla sua deviazione dalla simmetria cilindrica; la grandezza fisica che misura questa disomogeneità è chiamata momento di quadrupolo. Quando il momento di quadrupolo di un corpo di grande massa subisce variazioni molto rapide, in seguito ad esempio alla rapidissima rotazione di una massa non uniformemente distribuita, dovrebbe essere emesso un treno di onde gravitazionali di intensità proporzionale alla velocità delle variazioni. Questo è il caso per esempio di una stella doppia, classico sistema isolato a due corpi interagenti che si muovono di moto reciproco.

In particolare, quando un sistema binario giunge alla fine della sua vita, le stelle che lo compongono precipitano rapidamente verso il centro di massa lungo una traiettoria a spirale, fino a che collidono e si disintegrano, emettendo per l'appunto onde gravitazionali. Ma l'emissione in questo caso è probabilmente troppo tenue per essere rivelata. L'impulso di onde gravitazionali dovrebbe essere molto più intenso se a ruotare e a collidere sono due stelle di neutroni, a causa della massa assai maggiore. Anche l'esplosione di una supernova dovrebbe essere annunciata dalla trasformazione di circa lo 0,1 % della massa iniziale in onde gravitazionali, ed idem dicasi per la formazione di buchi neri (§ 5.7). Particolarmente importante in questo senso è PSR B1913 +16, il primo sistema binario costituito da due stelle di neutroni ad essere scoperto nel 1974 ad opera di Alan Russell Hulse (1950-) e Joseph Hooton Taylor (1941-) dell'Università del Massachusetts Amherst; per la loro scoperta, i due ricercatori furono insigniti nel 1993 del Premio Nobel per la Fisica. La variazione del periodo di rivoluzione del sistema binario PSR 1913+16 si rivelò essere identica a quella prevista dalla Relatività Generale, ed è molto probabile che tale sistema irraggi onde gravitazionali in grande quantità.

Ancora più eclatante è la scoperta di due buchi neri in rapida rotazione l'uno attorno all'altro, separati da una distanza inferiore alla dimensione del sistema solare, nel cuore di una galassia lontana da noi 3,5 miliardi di anni luce. Questo fenomeno sarebbe responsabile dello strano comportamento di un particolare quasar, indicato con la sigla PG 1302-102: di solito i quasar passano dall'essere luminosi a oscuri in modo apparentemente casuale, mentre questo emette luce in maniera insolitamente periodica e intensa, aumentando di luminosità del 14 % ogni cinque anni. La scoperta, avvenuta nel 2015, la dobbiamo a un gruppo di ricercatori del California Institute of Technology guidati da Matthew Graham. Per effetto Doppler, la materia che si muove vicino alla velocità della luce sembra cambiare di luminosità in funzione della posizione, e ciò spiegherebbe la periodicità del quasar; il gruppo di studiosi ha usato una simulazione al computer di due buchi neri rotanti per prevedere in che modo varierebbe la luce ultravioletta emessa dal quasar, confrontando poi il risultato con i dati raccolti in vent'anni di osservazioni, e la previsione del modello è risultata corretta. Naturalmente la presenza di un sistema binario di buchi neri non è l'unica spiegazione per lo strano comportamento del quasar PG 1302-102: tra le spiegazioni alternative vi sono la deformazione nel disco di materia attorno al buco nero o un hot spot nel disco di accrescimento.

Ma non bisogna dimenticare il Big Bang: come si è detto, esso ha lasciato una radiazione di fondo fatta di microonde (§ 7.4), ma anche un rumore di fondo di onde gravitazionali. emesse nei primi istanti di vita dell'Universo, cioè i 'tremori' successivi Big Bang. L'esperimento Background Imaging of Cosmic Extragalactic Polarization (BICEP), coordinato da John Kovac, ha tentato di osservare la radiazione cosmica di fondo per scovarvi le prime evidenze dirette delle onde gravitazionali e dell'inflazione. L'esperimento BICEP, installato nella base Amundsen-Scott nei pressi del Polo Sud, ha osservato la radiazione cosmica di fondo per verificare che le piccolissime differenze di densità fra le varie regioni dello spazio dopo il Big Bang sono state effettivamente amplificate dall'inflazione. Ma, oltre a queste perturbazioni, i modelli prevedono che nella fase inflazionaria siano state emesse delle onde gravitazionali primordiali, causate da perturbazioni del campo gravitazionale. Queste onde gravitazionali, propagandosi nello spazio, avrebbero interagito successivamente con la radiazione cosmica di fondo, lasciando una "firma" caratteristica. BICEP è andato a caccia di quella firma, che si è manifestata nella polarizzazione della radiazione di fondo (la polarizzazione è una delle proprietà delle onde elettromagnetiche, consistente nell'immutata direzione di oscillazione del campo elettromagnetico). Il 17 marzo 2014 John Kovac e colleghi hanno annunciato di aver scoperto alcuni particolari modi di polarizzazione, detti modi B, che secondo loro rappresentano proprio la prima evidenza indiretta delle onde gravitazionali primordiali, ma nel giugno successivo gli autori della suddetta scoperta hanno informato la comunità scientifica che l'effetto di polarizzazione della radiazione a microonde da essi captato era invece causato dalla minuta polvere cosmica presente nella nostra galassia, piuttosto che dalle onde gravitazionali, come ha confermato il satellite Planck dell'ESA.

L'interferometro VIRGO, che il 14 agosto 2017 ha captato la sua prima onda gravitazionale

Purtroppo la caccia alle onde gravitazionali è tutt'altro che semplice, a causa della loro estrema debolezza, visto che la gravitazione è l'interazione meno intensa, tra le quattro della natura: i calcoli ci dicono che le onde prodotte dalla formazione di un buco nero o dal collasso di due stelle a neutroni, investendo la Terra, dovrebbero produrre uno scostamento dalla metrica cartesiana (7.6) di appena 10−21 metri per ogni metro di lunghezza, e tale oscillazione corrisponde ad appena un milionesimo del diametro di un protone! Tutto ciò rende davvero problematico rilevare onde gravitazionali con le tecnologie a nostra disposizione, ma gli sforzi negli ultimi anni si stanno moltiplicando. Basti pensare al progetto AURIGA (Antenna Ultracriogenica Risonante per l'Indagine Gravitazionale Astronomica), un rivelatore tutto italiano di onde gravitazionali costruito nel 1991 e basato su un'antenna mantenuta a temperatura prossima allo zero assoluto, e al grande rivelatore interferometrico Virgo (simile ad un interferometro di Michelson), con bracci lunghi 3 km, situato in località Santo Stefano a Macerata, nel comune di Cascina (PI), in funzione dal 2003 e frutto di una collaborazione italo-francese nell'ambito del consorzio EGO (European Gravitational Observatory). Ancora più avanzato è il progetto LIGO (Laser Interferometer Gravitational-Wave Observatory, "osservatorio interferometrico laser di onde gravitazionali"), esperimento avviato nel 2004 presso Washington da ricercatori del California Institute of Technology e del Massachusetts Institute of Technology. LIGO e VIRGO in pratica sono due enormi tubi lunghi rispettivamente 4 e 3 chilometri perpendicolari l'uno all'altro. In ognuno di questi tubi c'è un raggio laser che viene riflesso una cinquantina di volta da particolari specchi, così da allungarne il percorso. Se passa un'onda gravitazionale, essa dilata lo spazio in una direzione e lo accorcia nella direzione ortogonale alla prima per una lunghezza di miliardesimi di miliardesimi di miliardesimi di metro. Allungando lo spazio, la luce laser quindi impiega più tempo per attraversare uno dei due bracci di Virgo o di Ligo, mentre ne impiega di meno nel braccio ortogonale dove lo spazio si è ristretto. Analizzando con precisione estrema i tempi di anticipo e di ritardo (ed eliminando qualsiasi tipo di disturbo), si riesce a captare l'onda gravitazionale.

Inoltre, il 3 dicembre 2015 alle 5.04 ora italiana con un vettore VEGA è stato lanciato con successo dal poligono spaziale di Kourou, nella Guyana francese, il satellite europeo LISA Pathfinder, realizzato da un cordata di aziende e centri di ricerca europei guidati da Airbus Defence and Space, ed ideato per studiare queste sfuggenti « vibrazioni » dell'universo. Esso si è posizionato nel punto lagrangiano L1, a 1,5 milioni di chilometri da noi, dove (come si è visto) la forza di gravità del Sole e della Terra si annullano. Scopo della missione, realizzata con il contributo del 13 % dell'Agenzia Spaziale Italiana, è quello di verificare il funzionamento delle tecnologie che serviranno per lo sviluppo dell' ambiziosa missione eLISA (evolved Laser Interferometer Space Antenna) da 2 miliardi di euro, che prevede l'invio di una costellazione di tre satelliti co-orbitanti, liberi di fluttuare alla distanza di 2,5 milioni di chilometri l'uno dall'altro, e collegati tra loro a formare un gigantesco interferometro spaziale, che dovrebbe essere pienamente compiuto entro il 2035.

E proprio dagli abissi dell'universo è arrivata, l'11 febbraio 2016, la tanto attesa notizia: nel corso di una conferenza stampa in contemporanea ai due lati dell'Atlantico, le collaborazioni LIGO e VIRGO hanno annunciato la prima osservazione di onde gravitazionali, avvenuta alle 10.50 e 45 secondi ora italiana del 14 settembre 2015. È stato allora che i due strumenti dell'esperimento LIGO hanno registrato un dato anomalo; sono iniziate subito le conferme per avere la sicurezza. Le onde gravitazionali rivelate sono state prodotte nell'ultima frazione di secondo del processo di fusione di due buchi neri a 410 Megaparsec da noi, di massa equivalente a circa 29 e 36 masse solari, in un unico buco nero rotante più massiccio di circa 62 masse solari: le tre masse solari mancanti al totale della somma equivalgono all'energia emessa durante il processo di fusione dei due buchi neri, sotto forma di onde gravitazionali. I due buchi neri, prima di fondersi, hanno percorso una traiettoria a spirale per poi scontrarsi a una velocità pari circa alla metà della velocità della luce. L'osservazione conferma anche l'esistenza di sistemi binari di buchi neri di massa stellare, in particolare aventi massa maggiore di 25 masse solari. Il processo di fusione dei due buchi neri responsabile delle onde gravitazionali rivelate è un evento accaduto quasi un miliardo e mezzo di anni fa, quando sulla Terra facevano la loro comparsa le prime cellule evolute in grado di utilizzare l'ossigeno. « Questo risultato rappresenta una pietra miliare nella storia della fisica, ma ancor più è l'inizio di un nuovo capitolo per l'astrofisica», ha commentato Fulvio Ricci, professore all'Università La Sapienza di Roma e ricercatore dell'INFN che coordina la collaborazione internazionale Virgo. « Osservare il cosmo attraverso le onde gravitazionali cambia radicalmente le nostre possibilità di studiarlo: finora è come se lo avessimo guardato attraverso radiografie, mentre adesso siamo in grado di fare l'ecografia del nostro universo ». Finora infatti lo studio del cosmo è stato realizzato solo attraverso i segnali emessi da stelle e galassie nello spettro elettromagnetico (luce visibile, raggi X e gamma, infrarossi, ultravioletti, onde radio di varia lunghezza d'onda). L'esistenza delle onde gravitazionali apre un mondo nuovo: la possibilità di studiare l'universo e i suoi misteri in modo completamente differente. Oltre che « vederlo », saremo in grado anche di « sentirlo » nella sua essenza più fondamentale, lo spazio-tempo, e capire come e perché l'universo non solo si espande, ma sta addirittura accelerando la sua velocità di ampliamento. « Questo risultato rappresenta un regalo speciale per il centesimo anniversario della Relatività Generale », ha concluso Fernando Ferroni, presidente dell'INFN. « È il sigillo finale sulla meravigliosa teoria che ci ha lasciato il genio di Einstein, ed è anche una scoperta che premia il gruppo di scienziati che ha perseguito questa ricerca per decenni, e alla quale l'Italia ha dato un grande contributo ».

Il 14 agosto 2017, alle ore 12.30.43 ora italiana, finalmente anche l’interferometro europeo VIRGO di Cascina ha captato un’onda gravitazionale: è stata la prima captata dal nostro osservatorio nazionale! Anche questa nuova onda è scaturita dalla fusione di due buchi neri lontani 1,8 miliardi di anni luce dalla Terra, rispettivamente di 31 e 25 masse solari rispettivamente. L'equivalente di una massa solare è stato così trasformato in un'onda di energia gravitazionale, indicata con la sigla GW170814. Decisivo è stato l'apporto di Alessandra Buonanno, uno dei tre direttori del Max Planck Institute for Gravitational Physics di Potsdam, in Germania, esperta delle tecniche di filtraggio dei dati. Si consolida così una pratica sperimentale in campo astronomico e astrofisico che fino a pochi anni fa sembrava quasi fantascienza: non si tratta solo di un fondamentale punto di arrivo, ma anche e soprattutto dell'inizio di un campo di studi inesplorato: l'astronomia a onde gravitazionali. Le nuove misurazioni hanno infatti dato ulteriore conferma della presenza nell'universo di buchi neri con massa maggiore di 20 masse solari, di cui non si conosceva l'esistenza prima dei successi di LIGO.

Il successivo 17 agosto, alle 14.41 ora italiana, è stata rilevata anche la prima emissione di onde gravitazionali prodotta dalla fusione di due stelle di neutroni da parte degli osservatori gemelli LIGO e VIRGO. Questo evento, indicato con la sigla GW170817, oltre a essere il primo segnale gravitazionale confermato ad essere prodotto dalla fusione di una coppia di stelle di neutroni e non di buchi neri, è stato accompagnato dall'emissione di un lampo di raggi gamma, osservato dai satelliti Fermi della NASA e INTEGRAL dell'ESA nella galassia NGC 4993, in direzione della costellazione dell'Idra, e identificata 11 ore dopo. Qui sopra potete vedere l'osservazione del lampo di raggi gamma da parte del satellite INTEGRAL. È proprio questa controparte elettromagnetica delle onde gravitazionali a indicare che la sorgente, denominata AT2017gfo, è diversa da una fusione di buchi neri. Stando agli attuali modelli astrofisici, le due stelle, di 1,1 e 1,2 masse solari rispettivamente, per un diametro di soli 20 chilometri, iniziarono a ruotare freneticamente l'una intorno all'altra fino a scontrarsi: in quest'ultimo processo, durato circa 100 secondi, si sono prodotte le onde gravitazionali. Ecco perché, quando LIGO e VIRGO "vedono" un'onda gravitazionale, scatta l'allerta negli osservatori astronomici di tutto il mondo: in questo caso sono stati coinvolti 70 telescopi a terra e tutti gli osservatori spaziali a nostra disposizione. Da tempo si ipotizzava che i lampi di raggi gamma avessero origine proprio dalla fusione di stelle di neutroni; tra l'altro, le onde gravitazionali e il lampo di raggi gamma sono arrivati sulla Terra a meno di due secondi di distanza l'uno dall'altro, dopo un viaggio durato 130 milioni di anni! È una misura diretta e incredibilmente precisa del fatto che onde gravitazionali e la luce hanno la stessa velocità: si tratta quindi una conferma di quanto previsto dalla teoria della Relatività.

Aggiungiamo che il 21 maggio 2019 gli interferometri LIGO e VIRGO hanno captato un’onda gravitazionale insolita, indicata con la sigla GW190521, dovuta alla collisione di due buchi neri che si sono fusi insieme, rivelando qualcosa mai osservato prima, e ciò inevitabilmente porta con sé nuovi interrogativi. I due oggetti infatti misuravano rispettivamente 66 e 85 masse solari, e si sono scontrati e fusi assieme in un buco nero più grande. È la coppia più massiccia mai osservata ad aver generato un'onda gravitazionale, e quello più massiccio è davvero oversize, tanto che non c'è una spiegazione univoca su come possa essersi formato. Infatti 65 masse solari sono il massimo che, secondo i modelli, può nascere da una stella molto massiccia che collassa su se stessa. Quelli più grandi devono essersi formati in un altro modo. Invece 85 masse solari è una taglia che ricade in quello che viene definito "mass gap dell’instabilità di coppia": insomma, è un buco nero che "non dovrebbe esistere", proprio perché secondo la teoria il limite massimo per un buco nero generato da una stella è attorno alle 65 masse solari. Per stelle al di sopra di una certa massa, si genera a loro interno un fenomeno detto "instabilità di coppia" che può portare a due conclusioni. 1) Stelle più piccole, in questo range, subiscono pulsazioni, perdono massa e riacquistano stabilità, per dare vita a un buco nero di circa 30 masse solari. 2) Per stelle più massicce, fino a 250 masse solari, l'instabilità porta a un'esplosione devastante, una "supernova da instabilità di coppia" che non lascia dietro a sé alcun buco nero. Per questo non ci aspetteremmo di trovare buchi neri di questa massa, tra le 65 e 120 masse solari. Teoricamente, stelle con massa superiore a 250 masse solari potrebbero collassare direttamente in un buco nero, ma non ne conosciamo di così massicce. Lì in mezzo c’è dunque un "deserto" di buchi neri, caselle vuote che gli astrofisici cominciano a riempire.

Questa sarebbe appunto la prima volta che si riesce ad avere un segnale da un esemplare di buco nero di questo tipo grazie alle onde gravitazionali. Inoltre dopo, essersi scontrati, al loro posto dovrebbe esserci ora un buco nero di massa intermedia, pari a 142 masse solari, il primo mai trovato tra le 100 e le 1.000 masse solari. Così, dopo il recente annuncio della scoperta di qualcosa a metà tra una stella di neutroni e un buco nero, abbiamo riempito qualche altra lacuna, anelli mancanti nella catena degli oggetti cosmici. Questo evento potrebbe persino spingerci a ripensare i modelli che attualmente descrivono le fasi finali della vita di una stella massiccia! Si noti che il buco nero risultante è più leggero della somma dei due originari, perché la massa mancante è stata trasformata in energia! L'equivalente di otto soli annichilatisi che, sotto forma di onde gravitazionali, hanno fatto vibrare gli interferometri sulla Terra a sette miliardi di anni luce di distanza. Tra i record di questa osservazione, durata solo 0,1 secondi, c'è anche il fatto di essere il più lontano evento mai osservato grazie alle onde gravitazionali. Analizzando il segnale è emerso anche che uno dei due buchi neri iniziali ruotava velocemente, e che questa rotazione ha causato anche la rotazione del piano dell’orbita. Un indizio sull’ambiente circostante, insomma: molto instabile, forse affollato di altre stelle. Ed è proprio all'interno di ammassi popolati da moltissime stelle concentrate in poco spazio che si sono cercati, finora, i buchi neri di massa intermedia. Una delle teorie ipotizza infatti che possano originarsi da collisioni di stelle massicce: buchi neri in questo mass gap di instabilità si possono originare dalla fusione di buchi neri più piccoli, e questo è il secondo che osserviamo dopo l’evento di onde gravitazionali del 29 luglio 2017, oppure dalla coalescenza di due stelle supermassicce. Però queste formerebbero un buco nero singolo, mentre in GW190521 esso faceva parte di una coppia. Ma se si trovasse in un ammasso stellare, avrebbe più probabilità di trovare un compagno. Esistono anche teorie più esotiche, per le quali propendono alcuni cosmologi, come quelle dei buchi neri primordiali che non si formano da stelle ma da collassi dovuti a instabilità gravitazionali della materia primordiale nelle fasi immediatamente seguite al Big Bang. Ma questo aprirebbe tutto un altro discorso.

Il 29 giugno 2021, poi, Virgo, Ligo e Kagra hanno dato l'annuncio della prima rilevazione di due eventi di onde gravitazionali prodotte dalla fusione di due sistemi binari misti composti da un buco nero e una stella di neutroni. Si tratta di due segnali registrati il 5 e il 15 gennaio 2020, che confermano l'esistenza di una classe di fenomeni previsti dagli astrofisici già da diversi decenni, ma fino a oggi mai osservati. In entrambi i casi, la forma del segnale registrato ha reso possibile la sua attribuzione a un evento di coalescenza che ha coinvolto un buco nero e una stella di neutroni, i quali, al termine di un vorticoso "balletto cosmico" di avvicinamento che li ha visti ruotare l'uno intorno all'altro, si sono fusi in singolo corpo celeste estremamente compatto. I segnali, denominati GW200105 e GW200115 - codici che identificano anno, mese e giorno dell'osservazione dell'onda gravitazionale (GW) -, hanno fornito importanti informazioni sulle caratteristiche fisiche dei sistemi che li hanno emessi, come le masse delle sorgenti primarie e la distanza di queste ultime rispetto al nostro pianeta. Le analisi di GW200105 hanno infatti mostrato come le masse del buco nero e della stella di neutroni a esso associati fossero, rispettivamente, circa 8,9 e 1,9 volte quella del nostro Sole, consentendo inoltre di stabilire che la loro fusione è avvenuta 900 milioni di anni fa. Per quanto riguarda il secondo segnale, gli scienziati delle collaborazioni Virgo e LIGO hanno invece stimato che GW200115 sia stato prodotto da due corpi celesti di quasi 5,7 (buco nero) e 1,5 (stella di neutroni) masse solari, entrati in collisione circa un miliardo di anni fa. Questa scoperta ci ha permesso di svelare eventi catastrofici mai osservati finora, contribuendo a far luce su un paesaggio cosmico finora inesplorato.

Bisogna però tenere conto di un'altra straordinaria proprietà delle onde gravitazionali: esse possono alterare in modo permanente lo spazio dopo averne attraversato una certa regione! In pratica, sarebbe come se le onde oceaniche distorcessero in modo permanente la superficie del mare in continuo movimento. Le onde sono per definizione fenomeni transitori: una volta che l'onda è passata, ne sparisce ogni traccia. Ma allora, come può esistere questo effetto, noto come memoria delle onde gravitazionali? Secondo l'intuizione originaria di Einstein, qualsiasi azione o movimento o evento asimmetrico porta alla creazione di onde gravitazionali, e le onde gravitazionali stesse presentano tali asimmetrie. Un'onda gravitazionale mentre passa distorce lo spazio, avvicinando gli oggetti prima di riportarli alla loro posizione originale; questa distorsione dello spazio è essa stessa un evento asimmetrico che crea una nuova serie di onde gravitazionali che si propagano sulla scia della prima. Queste nuove onde a loro volta distorcono lo spazio e avvicinano gli oggetti; questa seconda onda ne genera una terza, che ne produce una quarta, e così via. Ogni serie di onde è più debole rispetto alla precedente, ma calcoli accurati rivelano che sommando i contributi sempre più ridotti delle infinite onde generate si ottiene una distorsione permanente: una volta passate le onde iniziali, due oggetti liberamente fluttuanti rimarranno per sempre più vicini l'uno all'altro di quanto non lo fosse all'inizio. I nostri rivelatori di onde gravitazionali hanno il potenziale per misurare l'"effetto menemonico", che è intenso all'incirca quanto l'influenza gravitazionale dell'onda iniziale; nonostante questo, tuttavia, tale effetto non è ancora stato rilevato e per ora rimane una previsione puramente ipotetica e non verificata della Relatività Generale. Perchè? Per rilevare la memoria delle onde gravitazionali, sono necessarie due cose: lo strumento deve essere libero di fluttuare per "ricordare" l'impronta delle onde gravitazionali, ed è necessario misurare gli effetti delle onde gravitazionali su tempi lunghi, perché l'effetto memoria impiega un po' di tempo ad accumularsi dopo il passaggio dell'onda iniziale. Purtroppo i nostri attuali rivelatori di onde gravitazionali falliscono su entrambi i fronti. LIGO usa masse attaccate a pendoli, che ripristinano meccanicamente la loro posizione dopo il passaggio di un'onda, offuscando qualsiasi misura di memoria, ed è stato messo a punto per i treni di onde gravitazionali a breve termine e ad alta frequenza. Tuttavia come si è detto intorno al 2035 l'Agenzia Spaziale Europea dovrebbe lanciare nello spazio la missione eLISA, che dovrebbe essere in grado di rilevare la memoria delle onde gravitazionali misurando la distorsione permanente dello spazio all'interno del sistema solare dopo il passaggio delle suddette onde, anche se essa sarà non più grande di un nucleo atomico. In che modo ciò potrebbe esserci utile? Quando due oggetti giganti si scontrano da qualche parte nel cosmo, possono farlo a qualsiasi angolo dal nostro punto di vista, e noi non abbiamo un modo efficace per determinare tale angolo, il che rende più difficile sapere a che distanza si sono verificate tali fusioni. Le osservazioni dell'effetto memoria possono eliminare questa confusione perché l'effetto memoria ha una diversa dipendenza dalla distanza e dall'angolo di osservazione, e quindi la misurazione combinata fornisce un quadro più dettagliato dello scenario in cui le onde gravitazionali si sono generate.

E il 3 ottobre 2017 è arrivata la ciliegina sulla torta: Kip Thorne (1940-, fondatore di LIGO e consulente scientifico del kolossal di fantascienza "Interstellar"), Ray Weiss (1932-) e Barry Barish (1936-) hanno vinto il Premio Nobel per la Fisica per la prima rivelazione delle onde gravitazionali. La motivazione del premio ha citato anche il nostro interferometro VIRGO di Cascina. Si tratta solo dell'ennesimo trionfo per la genialità di Albert Einstein. Dopotutto, nella sua canzone disco di platino intitolata "La Cura" (1996), anche il grande Franco Battiato cantava:

« Conosco le leggi del mondo,

e te ne farò dono:

supererò le correnti gravitazionali,

lo spazio e la luce per non farti invecchiare... »

.

8.3 I quanti di gravità

Come ha scritto Kip Thorne, se nell'intero corso della nostra vita avessimo visto l'oceano soltanto in un giorno molto calmo, non conosceremmo nulla sul mare grosso e sulle onde impetuose che accompagnano una forte tempesta. Questa situazione è analoga a quella in cui si trova oggi la nostra conoscenza dello spazio e del tempo incurvati dalla gravità: sappiamo pochissimo riguardo a come lo spazio e il tempo curvi si comportano nel corso di una"tempesta", ovvero quando la forma dello spazio e la velocità dello scorrere del tempo oscillano in modo estremo: questa è stata da lui definita un'affascinante frontiera della conoscenza umana. John Archiabald Wheeler battezzò questo ramo della fisica con il nome di geometrodinamica: essa ha lo scopo di descrivere il comportamento estremamente dinamico della geometria dello spazio e del tempo. Fino a poco tempo fa i tentativi di esplorare la geometrodinamica nelle ricerche sperimentali si è scontrata con la difficoltà di risolvere le equazioni di Einstein nel caso di fluttuazioni violente dello spaziotempo, e con l'incapacità di osservare gli effetti della geometrodinamica nell'universo conosciuto. La scoperta delle onde gravitazionali, unitamente all'uso di supercomputer in grado di fornire soluzioni numeriche affidabili delle equazioni della Relatività Generale, ha in parte colmato questa lacuna, vista la rapidità con cui tali onde attraversano il cosmo, modificandone per breve tempo la curvatura. Per questo Kip Thorne ha definito le onde gravitazionali « il lato curvo dell'universo »: essendo fatte a tutti gli effetti di spazio e tempo curvi, esse costituiscono lo strumento ideale per sondare il lato curvo (e infatti lo stesso Thorne è stato uno dei fondatori del progetto LIGO).

Se però vogliamo unificare le quattro forze della natura, e quindi anche la gravità, le onde gravitazionali da sole non bastano: diventa necessario mettere a punto una teoria quantistica della gravitazione, cioè una descrizione della gravitazione in grado di conciliare la meccanica quantistica e la relatività generale. Lo sviluppo di una valida teoria della gravità quantistica ci offrirebbe peraltro la sola strada possibile per accedere all'origine del big bang e al destino finale dei buchi neri, eventi che come vedremo si possono considerare caratteristici dell'inizio e della fine dell'universo. Purtroppo queste due teorie sembrano di primo acchito del tutto incompatibili. La teoria quantistica dei campi, che a tutt'oggi rappresenta la miglior descrizione possibile del mondo delle particelle elementari e delle interazioni tra di esse, funziona nella metrica cartesiana e nello spazio-tempo piatto di Minkowski (7.6), tipico della relatività ristretta; invece la Relatività Generale descrive la gravitazione come una curvatura dello spazio-tempo e non ammette traiettorie multiple, ciascuna delle quali descritte da una funzione d'onda e quindi da una determinata probabilità. Il conflitto appare a prima vista del tutto insanabile.

Il modo più semplice per combinare le due teorie dovrebbe essere quello di trattare semplicemente la gravità come un altro campo quantistico. L'elettrodinamica quantistica messa a punto da Richard P. Feynman (1918-1988) descrive tutte le interazioni come uno scambio di particelle virtuali. Consideriamo due giocatori di basket: il primo ha la palla e la passa al compagno che va a canestro. Quando il primo lancia la palla, cede ad essa parte della propria quantità di moto e cambia traiettoria; allo stesso modo, quello che riceve la palla modifica a sua volta la propria direzione e va a fare canestro. La medesima cosa succede tra due elettroni. Quando si avvicinano tra loro, il primo cede al secondo un fotone, detto "virtuale" perchè impossibile da rivelare. Avendo perso un quanto di quantità di moto, entrambi gli elettroni modificano la propria traiettoria, cambiando direzione come se si fossero respinti senza toccarsi. Tale fenomeno può essere descritto attraverso un "diagramma di Feynman", certamente una delle più geniali intuizioni di questo scienziato.

Allo stesso modo, allora, l'interazione gravitazionale tra due particelle dotate di massa dovrebbe essere mediata da una particella virtuale chiamata gravitone, di massa nulla e spin pari (2 per la precisione), in modo da dare vita ad una forza di raggio infinito ed unicamente attrattiva:

Ben presto però ci si accorse che, se le cose stessero così, il gravitone dovrebbe operare in maniera simile al fotone. Ma nell'elettrodinamica quantistica i fotoni agiscono direttamente l'uno sull'altro e sulle particelle cariche, mentre la gravità è prodotta da qualsiasi forma di energia per via dell'equazione di Einstein E = m c2 (si ricordi il campo gravitazionale che genera a sua volta ulteriore campo, come detto nel § 7.8); inoltre, tutti i tentativi di fondare una teoria quantistica coerente per la gravitazione si sono scontrati con il problema della rinormalizzazione: i quanti di gravità si attrarrebbero reciprocamente e il loro effetto si sommerebbe a tutte le interazioni, producendo per la forza valori infiniti che non possono essere rimossi con un artificio matematico, mentre ciò è possibile per le interazioni elettromagnetiche grazie appunto grazie ad una calibrazione opportuna delle costanti in gioco, nota come rinormalizzazione. A ciò si aggiunga il fatto che il gravitone trasporta un'energia piccolissima, e quindi rivelarne gli effetti tramite esperimenti diretti sarebbe tanto difficile quanto individuare le lievissime perturbazioni indotte dalle onde gravitazionali.

Questo è solo l'inizio dei gravissimi problemi offerti dal tentativo di mettere insieme una teoria quantistica della gravità. Uno dei più evidenti consiste nel fatto che, come diceva Feynman, « il mondo quantistico non è mai in quiete »: nella teoria quantistica dei campi, il valore del campo elettromagnetico in ogni punto fluttua continuamente. Di conseguenza, in un universo dominato dalla gravità quantistica la curvatura dello spazio-tempo e perfino la sua stessa struttura sarebbero soggette ad analoghe fluttuazioni. In una situazione del genere, lo stesso significato di passato, di futuro e di linea del tempo potrebbero essere rimessi in forse. Vediamo di approfondire questo concetto.

.

8.4 Il cono di luce quantistico

La Relatività Ristretta ci ha insegnato che, essendo la velocità della luce la stessa per tutti gli osservatori, le regioni dello spazio-tempo a noi accessibili si possono descrivere con l'aiuto di un particolare diagramma disegnato in un piano che ha lo spostamento x in ordinate e il tempo t, o meglio la coordinata complessa i c t, in ascisse: tale piano si dice cronotopo, e i suoi punti si chiamano eventi. Per semplicità ci limitiamo con questo a spostamenti lungo l'asse x, ignorando le altre due dimensioni spaziali. Le curve tracciate nel cronotopo sono chiamate linee di universo. Le due rette di equazione x = ± i c t rappresentano le bisettrici dei quadranti; e, siccome a meno del fattore i il prodotto ( c t ) rappresenta lo spazio percorso dalla luce nel tempo t (un metro è pari a circa 3,3 nanosecondi), i punti di queste bisettrici rappresentano quelli che possono raggiungere l'origine, o che possono essere raggiunti dall'origine, solo con un raggio di luce. Le aree tali che x < | i c t | sono invece quelle che possono essere raggiunte o che ci possono raggiungere da parte di un osservatore in moto a velocità inferiore a quella della luce (cioè da parte di un osservatore fatto di materia). Invece le aree tali che x > | i c t | sono assolutamente irraggiungibili, perchè per arrivarci bisognerebbe viaggiare più veloci della luce.

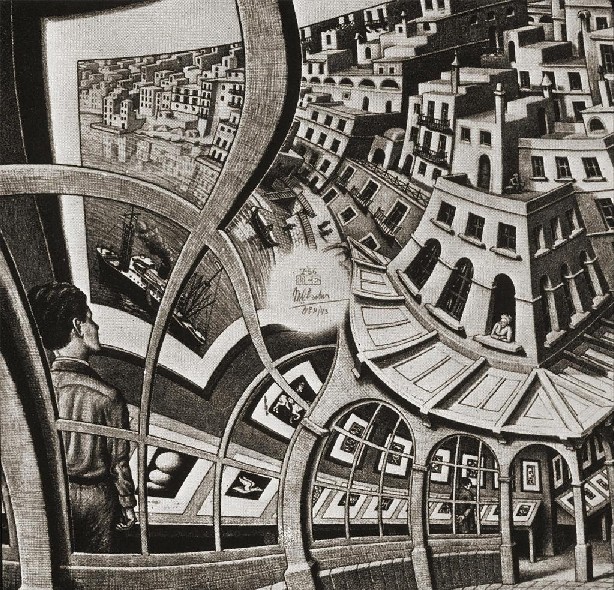

Il cono di luce relativistico

Questa struttura prende il nome di cono di luce perchè, aggiungendo la dimensione spaziale y, la zona colorata in azzurro assumerebbe proprio l'aspetto di un cono; per maggiori dettagli, si veda questa pagina. L'origine costituisce il nostro presente, quando x = 0 e t = 0. Un evento contenuto nell'area colorata in azzurro nel terzo e quarto quadrante può raggiungere l'origine, e quindi essa rappresenta il nostro passato. L'area colorata in azzurro nel primo e secondo quadrante può essere raggiunta da un raggio di luce che parte dall'origine, e quindi rappresenta il futuro. La nostra vita non può che svolgersi dal passato al futuro, passando per il presente. Una retta verticale rappresenta la linea di universo di un oggetto in quiete nel sistema di riferimento adottato. Una retta inclinata è la linea di universo di un oggetto in moto a velocità costante nel sistema di riferimento. Una linea universale curva rappresenta invece un oggetto che sta accelerando. Le due bisettrici sono le linee di universo dei fotoni. In questa situazione, il concetto di simultaneità dipende dal sistema di riferimento: due eventi collegati da una linea orizzontale in un dato sistema di riferimento sono simultanei in tale sistema, ma non in altri, mentre Newton insegnava che due eventi contemporanei per me lo sono anche per qualunque altro osservatore.

Questa rappresentazione geometrica non tiene però conto della Meccanica Quantistica, formulata nel 1925 da Werner Heisenberg (1901-1976) e da Edwin Schrödinger (1887-1961), e poi generalizzata nel 1928 da Paul Dirac (1902-1984) per tenere conto della Relatività Ristretta quando le particelle elementari si avvicinano alla velocità della luce. Alla metà degli anni trenta del XX secolo però era già chiaro che, quando si combina la meccanica quantistica con la relatività, si giunge a delle conseguenze sorprendenti. Se infatti la gravitazione è quantizzata, la forma del cono può fluttuare fortemente su brevi distanze, assumendo un aspetto fortemente ondulatorio. Ma allora alla domanda se due punti dello spazio-tempo possano comunicare l'uno con l'altro si può solo una risposta probabilistica. In altre parole, mentre il cono di luce classico sopra descritto ci permette di affermare con precisione assoluta se due eventi possono comunicare o no l'uno con l'altro, il cono di luce quantistico ci potrà solo dire quale probabilità essi hanno di comunicare. E siamo solo al principio.

.

Nella fisica classica uno spazio-tempo euclideo e assolutamente vuoto è privo di strutture, mentre nella fisica quantistica il concetto di « vuoto» designa un'entità più complessa, e dotata di una struttura complicatissima, dovuta all'esistenza nel vuoto di campi liberi che non si annullano mai, benché lontani dalle loro sorgenti. Infatti un campo elettromagnetico libero è equivalente a un insieme infinito di oscillatori armonici, che nel vuoto si trovano nel loro stato fondamentale, ovvero quello di minima energia. Quando un oscillatore classico si trova nel suo stato fondamentale, è immobile in un punto ben definito, ma ciò non può valere anche per un oscillatore quantistico, altrimenti la sua posizione sarebbe nota con precisione assoluta, e ciò è impossibile per il Principio di Indeterminazione di Heisenberg. Nello stato fondamentale di un oscillatore quantistico non è possibile dunque determinare esattamente né la posizione né la quantità di moto, entrambe soggette a fluttuazioni casuali.

Ora, nel 1976 il canadese William Unruh (1945-) della British Columbia University dimostrò che un ipotetico rivelatore di particelle sottoposto a un'accelerazione costante reagirebbe alle fluttuazioni del vuoto come se fosse in quiete in un gas di particelle con una temperatura proporzionale all'accelerazione, mentre un rivelatore non accelerato non reagirebbe affatto alle fluttuazioni. Questa scoperta ci ha costretti a ripensare il concetto di "vuoto quantistico". Per capire come, è utile un esperimento concettuale proposto dal solito Einstein, il quale come sappiamo come sperimentatore era una schiappa, però era insuperabile nel proporre esperimenti mentali. Allo scopo, si consideri un ascensore sigillato e perfettamente vuoto, con pareti perfettamente conduttrici e quindi impermeabili alla radiazione elettromagnetica, circondato a sua volta da un vuoto perfetto. L'ascensore a un certo punto inizia ad accelerare verso l'alto. Se l'ascensore fosse pieno d'aria, in esso si formerebbe un'onda acustica di compressione verso l'alto; allo stesso modo, è possibile dimostrare che il pavimento dell'ascensore comincia ad emettere una tenue onda elettromagnetica diretta verso l'alto, cioè in termini quantistici un tenue gas di fotoni che riempie la cabina. Cerchiamo ora di liberarci di questi fotoni mediante un opportuno refrigeratore, alimentato da una fonte di energia esterna. Esso in pratica estrae fotoni pompandoli all'esterno, così come si farebbe il vuoto estraendo molecole d'aria. Una volta eliminati tutti i fotoni, un rivelatore di fotoni misura l'energia del vuoto sia all'interno che all'esterno. Poiché il rivelatore all'esterno sta accelerando nel vuoto, esso è sensibile alle fluttuazioni quantistiche dei campi che permeano lo spazio anche in assenza di particelle. Invece il rivelatore all'interno è in quiete rispetto all'ascensore, e non sente le fluttuazioni. Ne consegue che i vuoti all'interno e all'esterno del montacarichi non sono affatto equivalenti! Se si attribuisce energia nulla al vuoto posto all'esterno del montacarichi, il vuoto all'interno deve avere energia minore di esso, e quindi... negativa!

Questa sì che è una sorpresa: cosa può voler dire che un vuoto ha un'energia minore di un altro vuoto che non ne ha? Che senso fisico ha dire "meno di niente"? Se tuttavia ci riflettiamo su un momento, capiremo che all'interno dell'ascensore devono essere aggiunti fotoni termici, affinché un rivelatore di Unruh all'interno di esso si comporti come nel vuoto standard all'esterno. Quando si aggiungono i fotoni, la loro energia riporta a zero l'energia totale interna, uguale a quella del vuoto esterno. Questo vuoto standard è l'equivalente quantistico dello spazio-tempo euclideo e vuoto della Relatività. Comunque è certo che, per il Principio di Equivalenza di Einstein (§ 6.3), secondo il quale gravità ed accelerazione sono tra loro indistinguibili, anche un campo gravitazionale può generare un vuoto con energia negativa, e questa è un'altra delle stranezze della gravità quantistica.

Come nel caso del classico paradosso dei gemelli, tuttavia, gli strani effetti del vuoto quantistico sarebbero difficili da osservare nella realtà quotidiana. Per le accelerazioni raggiungibili con la nostra tecnologia, ed anche con lo Space Shuttle, l'energia negativa è di unga troppo piccola per essere rilevata. Esiste però un caso nel quale è stata misurata un'energia negativa del vuoto, seppure indirettamente: stiamo parlando del cosiddetto Effetto Casimir, scoperto nel 1948 dal fisico olandese Hendrik Brugt Casimir (1909–2000) e sperimentalmente verificato nel 1996 da Steven Lamoreaux alla Washington Università di Seattle. Mentre lavorava al laboratorio di ricerca Philips nei Paesi Bassi, Casimir dimostrò che, ponendo nel vuoto spinto due sottili lamine metalliche piane, parallele, pulite e scariche, esse si attirano debolmente a vicenda. Il fenomeno è dovuto proprio alla densità di energia negativa nel vuoto che le separa.

In pratica, mentre all'esterno delle lamine le interazioni fra le particelle virtuali che si materializzano nel vuoto possono avvenire senza alcuna limitazione, tra le due lamine, a causa della loro piccola distanza, le stesse interazioni avvengono solo se la lunghezza d'onda dei fotoni virtuali è più piccola della distanza fra le piastre. Ciò genera una condizione di squilibrio fra il numero di eventi virtuali con i loro effetti reali che si verificano all'esterno e quello che nello stesso intervallo di tempo avviene all'interno delle lamine. Se h è la costante di Planck, c è la velocità della luce nel vuoto, S è la superficie affacciata delle lamine e d la loro distanza, la forza di Casimir è espressa dalla formula:

Il segno meno indica che la forza è attrattiva: la densità di energia decresce avvicinando le lastre. Ad esempio, nel caso di lamine poste alla distanza di 1 micron (10–6 m), la forza per unità di superficie che ne risulta è pari a circa 0,0013 N per metro quadrato.

L'effetto Casimir ha portato più di uno a pensare che proprio l'energia del vuoto potrebbe essere all'origine della misteriosa "energia oscura" di cui abbiamo parlato nel § 7.9. E non è tutto: certuni si sono spinti ad affermare che la stessa energia del vuoto potrebbe essere stata addirittura la causa scatenante del Big Bang. Esso infatti è partito, per quanto ne sappiamo, da una singolarità iniziale puntiforme, di dimensioni nulle e di densità, temperatura e curvatura infinite. Non è impossibile che una fluttuazione quantistica del "vuoto" iniziale abbia dato vita a un fenomeno non virtuale ma reale: una bolla di materia ed energia che si è gonfiata improvvisamente, crescendo fino a dare vita all'intero nostro universo. L'idea che il vuoto possa diventare una sorgente di energia e che questa possa essere creata dal nulla appare in netto contrasto con il consolidato Principio di Lavoisier ("Nulla si crea e nulla si distrugge"), ma la relatività e la meccanica quantistica ci hanno già costretti a modificare la maggior parte dei nostri consolidati principi fisici, e dunque questa ipotesi non appare più stravagante di quella del celebre Gatto di Schrödinger, che può essere al 50 % vivo e al 50 % morto, o dei due gemelli che si ritrovano ad invecchiare a ritmi diversi in due diversi sistemi di riferimento.

L'immagine di questo "vuoto" che genera prepotentemente universi dal nulla ci fa ritornare in mente il poema babilonese "Enuma Elish" del quale abbiamo parlato all'inizio della nostra trattazione:

« Quando in alto non aveva nome il Cielo,

quando in basso non aveva nome la Terra,

nulla esisteva eccetto Apsu, l'antico, il loro creatore,

e Mummu e Tiamat, la madre di loro tutti:

le loro acque si mescolavano insieme,

i pascoli non erano ancora stati formati, né i canneti esistevano;

quando nessuno degli déi si era ancora manifestato,

nessuno aveva un nome e i loro destini erano incerti.

Allora, in mezzo a loro presero forma gli Déi... »

Il cono di luce quantistico

.

8.6 La curvatura quantistica

Il vuoto diventa ancora più complicato quando lo spazio-tempo è curvato, come nella Relatività Generale. La curvatura infatti influenza la distribuzione spaziale delle fluttuazioni del campo quantistico e, come l'accelerazione, può indurre un'energia del vuoto non nulla. Dal momento che la curvatura può variare da punto a punto, può variare anche l'energia del vuoto, mantenendosi positiva in alcuni punti e negativa in altri.

Ora, in qualsiasi teoria coerente, l'energia si deve conservare. Supponiamo dunque che un aumento della curvatura provochi un aumento dell'energia del nostro vuoto quantistico. Tale energia deve pur venire da qualche parte, e quindi la stessa esistenza delle fluttuazioni del campo quantistico implica che sia necessaria dell'energia per curvare lo spazio-tempo. Insomma, lo spazio-tempo si oppone in qualche modo alla curvatura, proprio come una molla rigida oppone resistenza ad essere allungata.

Nel 1967 il famoso fisico russo Andrej Dimitrievic Sacharov (1921–1989), prima padre della bomba atomica sovietica e poi strenuo difensore dei diritti umani e Premio Nobel per la Pace, dimostrò che la gravitazione potrebbe essere un fenomeno puramente quantistico, derivante dall'energia del vuoto, e che la costante di Newton G (§ 2.2) o, in modo equivalente, la rigidità 1/G dello spazio-tempo, è derivabile non solo dall'esperienza, ma anche dai principi fondamentali della Meccanica Quantistica. Quest'idea rivoluzionaria incontrò però enormi difficoltà. In primo luogo, essa richiede che la gravità venga sostituita, come campo fondamentale, da un "campo di gauge di grande unificazione" legato alle particelle elementari note (campo di gauge è un campo dotato di particolari simmetrie). Si deve introdurre a questo punto una massa fondamentale per poter ottenere una scala assoluta di unità; e quindi una costante fondamentale viene sostituita da un'altra, senza particolari vantaggi.

In secondo luogo, la dipendenza calcolata dell'energia del vuoto dalla curvatura conduce a una teoria della gravità incredibilmente più complessa di quella di Einstein. Un vero vuoto è definito come uno stato di equilibrio termico allo zero assoluto. Nella gravità quantistica un tale vuoto può esistere soltanto se la curvatura è indipendente dal tempo. Quando la curvatura dipende dal tempo, nel vuoto possono apparire spontaneamente delle particelle dal nulla, con il risultato che non si tratta più di un vuoto. Il meccanismo di produzione di particelle può essere spiegato anche in termini di oscillatori armonici: quando cambia la curvatura dello spazio-tempo, cambiano anche le proprietà fisiche degli oscillatori del campo. Supponiamo che un oscillatore si trovi inizialmente nel suo stato fondamentale, soggetto quindi a oscillazioni di punto zero. Se cambia una delle sue proprietà, come la massa o la costante elastica della molla, le sue oscillazioni di punto zero devono a loro volta adattarsi alla variazione. Dopo l'adattamento c'è una probabilità finita che l'oscillatore non si trovi più nel suo stato fondamentale, ma in uno stato eccitato. Il fenomeno è analogo all'aumento di vibrazione indotto in una corda vibrante di un pianoforte quando aumenta la sua tensione; l'effetto è chiamato eccitazione parametrica. Nel campo quantistico, l'analogo dell'eccitazione parametrica è la produzione di particelle.

Le particelle prodotte da una curvatura variabile nel tempo appaiono casualmente. Non è possibile prevedere esattamente in anticipo dove o quando comparirà una data particella; si può però calcolare la distribuzione statistica dell'energia e della quantità di moto delle particelle. La produzione di particelle è massima dove la curvatura è massima e sta cambiando con la massima velocità. Essa fu dunque grandissima durante il Big Bang e potrebbe aver avuto un effetto predominante sulla dinamica dell'universo nei primi istanti: le particelle create per questa via potrebbero spiegare tutta la materia che vediamo sparsa nell'universo. Tuttavia, tutti i tentativi compiuti finora di calcolare il tasso di produzione di particelle durante il Big Bang non hanno mai condotto una soluzione definitiva, dato che non conosciamo quale stato quantico iniziale attribuire all'irraggiungibile istante del Big Bang. Nel 1965 Roger Penrose (1931–) delI'Università di Oxford dimostrò anzi che la teoria classica di Einstein è incompleta, prevedendo il verificarsi di quelle che vengono chiamate singolarità, cioè situazioni con densità, temperature e curvature infinite. Ma una teoria fisica che prevede un valore infinito per una grandezza osservabile non è più in grado di avanzare previsioni da quel punto in poi. Secondo la maggioranza degli scienziati, l'unico modo di sopperire all'incompletezza della teoria di Einstein è proprio la sua integrazione con gli effetti quantistici, perchè le fluttuazioni dei parametri ad esse dovute impedirebbero a densità, temperatura e curvatura di raggiungere i valori infiniti predetti da Einstein.

Un altro evento durante il quale la curvatura dell'universo dovrebbe cambiare rapidamente è il collasso di una stella che dà origine a un buco nero, del quale abbiamo già parlato nel § 5.7. Nel 1974 Stephen Hawking (1942–2018) dimostrò che la variazione di curvatura in vicinanza di un buco nero in fase di collasso crea un flusso stazionario di particelle, chiamato radiazione di Hawking, che sembra far "sgonfiare" il buco nero, anche se su tempi lunghissimi. La radiazione di Hawking "ruba" energia al buco nero, e di conseguenza la sua massa diminuisce. Il tasso di diminuzione è dapprima lentissimo, ma cresce rapidamente all'aumentare della temperatura. Alla fine il tasso di variazione diventa così elevato che le approssimazioni nei calcoli di Hawking non sono più valide, e gli effetti quantistici prevalgono su quelli gravitazionali. Non si sa che cosa accada da questo punto in poi: Hawking riteneva che il buco nero cessi di vivere con un lampo spettacolare, lasciandosi dietro una « singolarità nuda », cioè non protetta da un invalicabile orizzonte degli eventi. Purtroppo qualsiasi singolarità, nuda o meno, costituisce il fallimento di una teoria fisica, e quindi, se Hawking aveva ragione, non è incompleta solo la teoria di Einstein, ma pure la teoria dei quanti!

.

8.7 Le unità di Planck

Qualcuno potrebbe pensare che, se i fenomeni della natura fossero davvero soggetti alla gravità quantistica, sicuramente i suoi insoliti effetti dovrebbero essere già stati rilevati. Così invece non è perché, come tutti gli incredibili effetti della Relatività Ristretta (contrazione delle lunghezze, dilatazione dei tempi, la relatività della simultaneità, eccetera) si manifestano solo a velocità prossima a quella della luce, che per noi è pressoché irraggiungibile, così tutti gli effetti di natura quantistica della gravitazione sono confinati in una scala di lunghezze e di tempi straordinariamente piccola. Ma piccola quanto?

Proponiamoci di cercare un sistema di "unità naturali", basati sulle tre principali grandezze fisiche, e cioè la costante di gravitazione G, bastione della Fisica Classica; la velocità della luce c, simbolo della Relatività Ristretta; ed ovviamente la costante di Planck h, o meglio la costante h tagliata pari ad h/2π, caratteristica della Meccanica Quantistica. Come determinare una "unità naturale di lunghezza"? Fissiamoci sulle dimensioni fisiche di queste costanti. La costante di gravitazione G si misura in Newton per metro quadro su kilogrammo al quadrato, quindi:

[ G ] = [ N m2 / Kg2 ] = [ m3 Kg–1 s–2 ]

c è una velocità, per cui [ c ] = [ m s–1 ]. Quanto poi alla costante di Planck:

[ h ] = [ E / f ] = [ J / Hz ] = [ m2 Kg s–1 ]

Se vogliamo combinare queste tre grandezze in modo da ottenere una lunghezza, dovremo moltiplicarle dopo averle elevate ad opportuni esponenti:

E quindi, per le equazioni dimensionali sopra scritte:

![]()

Da cui:

![]()

Se ne deduce che deve essere:

Risolvendo il sistema si ottiene facilmente α = 1/2, β = – 3/2, γ = 1/2. Ne consegue che la nostra equazione dimensionale (8.1) assume la forma:

Chiameremo questa lunghezza fondamentale con il nome di lunghezza di Planck lP. La precedente ci dice che la sua espressione è:

ed essa vale lP = 1,616252 x 10–35 m. Analogamente si può introdurre una massa di Planck mP ed un tempo di Planck tP, partendo dalle equazioni dimensionali:

![]()

Le espressioni che si ottengono con calcoli analoghi a quelli ora svolti sono le seguenti:

che valgono rispettivamente mP = 2,17644 x 10–8 kg e tP = 5,39124 × 10–44 s.

Se si esprimono i parametri fondamentali dell'universo in unità di Planck, saltano agli occhi alcune sorprese. Ad esempio, il numero 1061 esprime sia l'età dell'universo, sia la Costante di Hubble-Lemaître, sia la radice quadrata della Costante Cosmologica in unità tP, ma anche il diametro dell'universo in unità lP e la sua massa in unità mP. Inoltre già Arthur Eddington aveva fatto notare che 1040 rappresenta ad un tempo il rapporto tra il raggio dell'universo e quello dell'elettrone, tra la forza elettrostatica e quella gravitazionale agente tra un elettrone e un protone, e la radice quadrata del numero di atomi dell'universo. Il reale significato di queste coincidenze numerologiche però ci sfugge, e forse ci sfuggirà per sempre.

Si potrebbero introdurre anche una temperatura di Planck e una carica elettrica di Planck, ma in tal caso bisogna introdurre nei calcoli altre due costanti fondamentali: la costante di Boltzmann KB e la costante dielettrica del vuoto ε0. Limitiamoci alle tre espresse dalle (8.2), (8.3) ed (8.4), dette unità di Planck: esse danno vita a un sistema assoluto di unità di misura. Come si verifica immediatamente, le unità di Planck sono completamente estranee alla fisica di ogni giorno: l'unità di lunghezza lP è dell'ordine dei 10–33 centimetri, e quindi è di 21 ordini di grandezza inferiore al diametro di un nucleo atomico; in altre parole, essa sta alle dimensioni nucleari come le dimensioni dell'uomo stanno a quelle della nostra galassia!

Ma allora, come possono esserci utili unità del genere? È presto spiegato. In meccanica quantistica si definisce lunghezza d'onda Compton di una particella la lunghezza d'onda di un fotone la cui energia è pari a quella della massa a riposo della particella. Usando il formalismo matematico, dovrà essere:

![]()

da cui si ricava che la lunghezza d'onda Compton vale:

Si può assegnare un limite inferiore alla lunghezza d'onda Compton (cioè un limite superiore all'energia di un fotone) se si impone un limite superiore alla massa m della particella. Per quanto detto nel § 5.7, possiamo pensare ad un limite superiore della massa di una particella quando questa raggiunge le dimensioni di un buco nero, all'interno del quale un fotone resta confinato dal campo gravitazionale. Ora, la (5.5) ci dice che, a meno del fattore 2, il raggio di Schwarzschild di un buco nero di massa m è:

Ricaviamo m da quest'ultima dopo aver posto R = λ e sostituiamola nella (8.5). Si trova facilmente:

La (8.6) coincide con la (8.2) a meno del fattore 2π nella costante di Planck ridotta. Risostituendo tale valore nella (8.5) si ottiene proprio l'espressione (8.3), sempre a meno del fattore 2π. Dunque la lunghezza di Planck è la misura del raggio dell'orizzonte degli eventi di una massa di Planck collassata in un buco nero! In altre parole, ogni fotone avente una lunghezza d'onda pari alla lunghezza di Planck può materializzarsi in una particella abbastanza massiccia da diventare un buco nero (detto "buco nero di Planck"), tale da distorcere lo spazio-tempo fino al punto di inghiottire quel fotone. Non possono quindi esistere lunghezze d'onda più piccole di così, perchè altrimenti la particella ottenuta dalla materializzazione del fotone non potrebbe nemmeno sussistere, essendo confinata per sempre all'interno del buco nero in cui essa è collassata! Grazie alla gravità quantistica abbiamo così trovato un limite inferiore per le lunghezze. Questo si traduce ovviamente in un limite inferiore per i tempi, non appena si osserva che la (8.2) e la (8.4) sono legate tra di loro da questa semplice relazione:

Il tempo di Planck è dunque quello impiegato dalla luce per coprire una lunghezza di Planck; non esistendo nulla che possa andare più veloce della luce, non ha senso pensare a tempi più brevi di tP.

Se non si può ragionare di distanze e tempo inferiori a quelli della scala di Planck, appare evidente che i concetti stessi di spazio e di tempo perdono di significato a quegli ordini di grandezza, e questo è considerato un indizio del fatto che la meccanica quantistica e la relatività generale non valgono più separatamente; a distanze paragonabili alla lunghezza di Planck quindi la gravità manifesta degli effetti quantistici. Ci conferma però l'impossibilità di accedere sperimentalmente a queste distanze non solo la loro estrema piccolezza, ma anche un'altra considerazione, legata alla cosiddetta energia di Planck EP. Essa rappresenta l'energia equivalente alla massa di Planck secondo la famosa equazione di Einstein EP = mP c2. Si ottiene facilmente:

![]()

Di qui si ricavano i 1019 GigaelettronVolt di cui abbiamo parlato sopra, indicandoli come l'energia alla quale avviene l'accoppiamento della gravità alle altre tre forze della natura. Come già accennato, però, per verificare sperimentalmente cosa accade a queste energie sarebbe necessario un acceleratore di particelle delle dimensioni della nostra Galassia!

.

8.8 Lo spazio-tempo schiumoso e l'iperspazio

Dopo aver stabilito questo nuovo sistema di unità di misura, possiamo inoltrarci nella parte più difficile della gravità quantistica. Quando un effetto quantistico, come la produzione di particelle o l'energia del vuoto, influenza la curvatura dello spazio-tempo, la curvatura medesima diventa un oggetto quantistico, come il cono di luce visto sopra. Per lunghezze d'onda grandi rispetto alla lunghezza di Planck, le fluttuazioni quantistiche del campo gravitazionale quantizzato sono piccole, e possono essere trattate come una debole perturbazione dei risultati classici. Ma alle lunghezze d'onda e alle energie di Planck, la situazione si fa decisamente più complicata. Le particelle mediatrici del campo gravitazionale, i gravitoni da noi introdotti nel § 8.3, sono così debolmente interagenti con la materia ordinaria, che perfino un'intera galassia è quasi totalmente trasparente per essi. I gravitoni interagiscono apprezzabilmente con la materia solo quando raggiungono le energie di Planck; come si è visto, a tali energie essi si comportano né più e né meno come dei nanobuchi neri, e dunque sono in grado di indurre curvature significative nella geometria dello spazio, e di distorcerla completamente.

Da notare come l'energia trasportata da un gravitone sia in grado di distorcere non solo la geometria dello spazio tempo (cioè il tensore metrico), ma pure le onde associate al gravitone stesso. Questa è una conseguenza della non linearità della teoria di Einstein: quando si sovrappongono due campi gravitazionali, il campo risultante non è uguale alla somma dei due campi componenti. La teoria della gravità quantistica è perciò fortemente non lineare. Di solito si trattano le non linearità con un metodo di approssimazioni successive chiamato teoria delle perturbazioni, basata sul perfezionamento di un'approssimazione iniziale mediante una serie di correzioni progressivamente più piccole. Nel caso della gravità quantistica però la teoria delle perturbazioni non è applicabile perchè, ad una scala di energie paragonabili a quelle di Planck i successivi termini della serie di perturbazioni (cioè le successive correzioni) non sono affatto trascurabili, e troncare la serie a un numero finito di termini non porta a un'approssimazione valida, poiché nel quantizzare il campo gravitazionale si quantizza lo stesso spazio-tempo. Nell'ordinaria teoria quantistica dei campi lo spazio-tempo è un fondale di teatro fisso. Nella gravità quantistica il fondo non solo reagisce alle fluttuazioni quantistiche, ma fluttua esso stesso!

Osserviamo allo scopo lo schema sottostante. Il vuoto quantistico, cui si è accennato nel § 8.5, diventa sempre più caotico ispezionando regioni di spazio sempre più minuscole. Alla scala del nucleo atomico (la prima in alto), che è anche la più piccola cui riusciamo finora ad accedere con i nostri apparati sperimentali, lo spazio appare praticamente piatto. 17 ordini di grandezza più in basso (al centro) compaiono nella geometria delle irregolarità e delle asperità. Alla scala della lunghezza di Planck, 1000 volte più piccola ancora (in basso), la curvatura e la topologia dello spazio sono continuamente sottoposte a violente fluttuazioni, che trasformano la stessa tessitura dello spazio-tempo (si noti: non la materia e l'energia, bensì la stessa geometria) in un ribollire caotico ed imprevedibile, una sorta di "schiuma" che sfugge ad ogni tentativo di rappresentazione analitica.

Da notare che nel giugno 2017 alcuni ricercatori italiani hanno annunciato una scoperta fondamentale: per la prima volta alcuni risultati sperimentali sono in buon accordo con la tessitura dello spazio-tempo non liscia ma schiumosa, finora confinata nel regno della speculazione teorica a causa soprattutto della difficoltà di rilevarne gl i effetti a una scala piccolissima. La svolta è stata data da modelli di schiuma spazio-temporale secondo cui le particelle che si muovo nello spazio arrivano fino alla Terra in un intervallo di tempo che dipende in lieve misura dall'energia delle particelle stesse e delle caratteristiche delle sorgenti. Queste ultime, a loro volta, sarebbero influenzate dall'esistenza di una struttura schiumosa dello spazio-tempo. L'occasione per osservare alcuni di questi effetti è offerta dai dati registrati dal telescopio spaziale Fermi della NASA a cui collaborano le agenzie spaziali di Italia, Francia, Giappone e Svezia, e da IceCube, un osservatorio per neutrini della National Science Foundation statunitense, costruito al Polo Sud. Giovanni Amelino Camelia e Giacomo D'Amico della "Sapienza" di Roma, in collaborazione con Niccolò Loret dell'Università di Zagabria e Giacomo Rosati dell'Università di Cagliari hanno effettuato un'analisi statistica dei dati relativi a fotoni e neutrini registrati con questi strumenti. Anche se il campione statistico è per ora limitato e non permette di trarre conclusioni definitive, i risultati sono in buon accordo con l'ipotesi della schiuma spazio-temporale.

Ma non è ancora finita. Uno spazio-tempo quantizzato possiede una struttura causale fluttuante e incerta anche per quanto riguarda il tempo. Alle dimensioni di Planck, difatti, la stessa distinzione passato e futuro diventa nebulosa. Per analogia con l'effetto tunnel nei sistemi quantistici, il quale consente a un elettrone di scavalcare una barriera energetica che potrebbe mai superare, dobbiamo aspettarci fenomeni non ammessi dalla tradizionale Relatività di Einstein, tra i quali viaggi su distanze di Planck a velocità superiori a quella della luce. Non sappiamo ancora come calcolare le probabilità di tali fenomeni, proprio per via dell'assenza in una teoria gravitazionale quantistica coerente.

John Archibald Wheeler propose una descrizione di questo spazio-tempo distorto davvero intrigante, quella della cosiddetta topologia fluttuante. Se le fluttuazioni nel campo gravitazionale, come quelle di tutti i campi, aumentano di intensità mano a mano che ci si avvicina alle lunghezze d'onda di Planck, estrapolando a questa scala i risultati della Relatività Generale di Einstein (vedi § 7.8) si deduce che le fluttuazioni diventano talmente violente da provocare dei "buchi" nello spazio-tempo, analogamente ai "wormhole" tanto cari alla fantascienza. In altre parole, Wheeler immagina il vuoto quantistico in uno stato di perenne agitazione, con la continua comparsa e scomparsa di cunicoli (ma anche di strutture assai più complesse) di dimensioni paragonabili a quelle planckiane. La creazione di questi "cunicoli" è percepibile solo al livello di Planck; a scale dimensionali maggiori, lo spazio-tempo continua ad apparire più regolare che mai.

Se l'affascinante interpretazione di Wheeler è corretta, in quale misura le fluttuazioni topologiche contribuiscono all'energia del vuoto, e come influenzano la resistenza alla curvatura macroscopica dello spazio-tempo? Ma soprattutto, qual è la possibilità che questi benedetti cunicoli si aprano, collegando due punti diversi dello spazio-tempo "schiumoso"? Apparirebbe logico rispondere: un cunicolo topologico ha maggiori probabilità di congiungere due eventi tra loro "vicini". Ma che cosa significa realmente "vicini", in una metrica completamente distorta rispetto a quella cui siamo abituati? Si pensi al famoso "iperspazio", introdotto nelle saghe di fantascienza di Isaac Asimov (il ciclo dei Robot e della Fondazione), in quella di "Star Wars" e in quella di "Babylon 5" per superare le distanze interstellari in alternativa al motore a curvatura di "Star Trek" e ai wormhole di "Stargate". Esso non è forse tale da rendere vicini in esso due eventi che nello spazio-tempo ordinario appaiono lontanissimi?

La "White Star" entra nell'iperspazio in una scena di Babylon 5

Come si intuisce, la "vicinanza" non è una proprietà intrinseca della struttura spaziotemporale; anzi, in genere richiede l'esistenza di uno spazio con un maggior numero di dimensioni nel quale sia immerso lo spazio-tempo ordinario, cui siamo abituati, e questo spazio a più dimensioni deve essere dotato di proprietà metriche assai diverse da quelle del "nostro" universo. Ma allora... lo spazio-tempo non e più l'universo! L'universo è qualcosa di più. Tutto questo potrebbe seriamente danneggiare la dimensionalità macroscopica dello spazio. Se infatti i cunicoli si possono formare spontaneamente, gli stessi cunicoli possono formare altri cunicoli, e cosi via all'infinito. Lo spazio potrebbe evolvere quindi in una struttura che, sebbene tridimensionale alla scala di Planck, presenti invece quattro o più dimensioni in una scala maggiore. Basti pensare alla comune schiuma, che è costituita interamente da superfici bidimensionali (le bolle), ma dal punto di vista macroscopico ha una struttura tridimensionale.

.

8.9 Le dimensioni "arrotolate"

È però vero anche il viceversa: la dimensionalità apparente dello spazio-tempo potrebbe anche essere inferiore alla sua dimensionalità reale. Questa è stata storicamente proprio la prima soluzione proposta per cercare di inserire elettromagnetismo e gravità in un'unica teoria coerente dei campi. A proporla per primi furono il tedesco Theodor Kaluza (1885–1954) e lo svedese Oskar Klein (1894–1977). Inizialmente Albert Einstein sottovalutò il loro lavoro, ma in seguito l'autore della teoria della Relatività si convinse che la loro era la strada giusta per giungere alla Teoria di Grande Unificazione cui egli aspirava, e li incoraggiò a pubblicarne i risultati. Mentre nella Relatività Ristretta lo spazio è tridimensionale e lo spazio-tempo è tetradimensionale, nella Teoria di Kaluza-Klein lo spazio è tetradimensionale e lo spazio-tempo è pentadimensionale. In pratica esiste una quarta dimensione spaziale, che noi non vediamo perchè è "arrotolata" lungo un cilindro con una circonferenza di diametro pari alla lunghezza di Planck (8.2), anziché essere "srotolata" come le altre tre lungo l'intera dimensione dell'universo, dell'ordine dei miliardi di anni luce. Nella Teoria di Kaluza-Klein, la traiettoria di tutte le particelle ha quindi una componente ciclica: ogni volta che raggiunge la massima estensione della dimensione arrotolata si ritrova al punto di partenza, e siccome questo continuo ruotare avviene lungo una scala spaziale miliardi di volte più piccola di un nucleo atomico, nessun esperimento a nostra disposizione può rivelarlo, e così noi non vediamo la quarta dimensione, ed abbiamo l'impressione che lo spazio sia tridimensionale.

Nonostante ciò, la quarta dimensione spaziale di Kaluza-Klein può manifestarsi in un altro modo, sotto forma di... luce. Kaluza e Klein infatti dimostrarono che se il loro spazio-tempo pentadimensionale viene trattato matematicamente allo stesso modo in cui lo spazio-tempo tetradimensionale viene trattato da Einstein, le componenti del campo elettromagnetico sono implicite nelle equazioni (7.10) in cui è coinvolta la curvatura dello spazio-tempo. Kaluza e Klein realizzarono in tal modo la prima valida teoria unificata dei campi, in grado di geometrizzare non solo la gravità, ma anche la radiazione elettromagnetica.

La Teoria di Kaluza-Klein conobbe un notevole successo negli anni venti, ma il suo problema era proprio la totale impossibilità di sottoporla a verifica sperimentale. Mentre la Gravitazione Universale di Newton si dimostrò in grado di prevedere correttamente l'esistenza e la posizione di Nettuno (§ 2.7), e la Relatività Generale riuscì a spiegare la deflessione della luce delle stelle (§ 6.8), la precessione del perielio di Mercurio (§ 6.9) e le lenti gravitazionali (§ 6.10), la teoria della quinta dimensione non prevedeva alcun nuovo fenomeno, e quindi non poteva essere confrontata con eventuali teorie alternative. La Teoria di Kaluza-Klein prevedeva effetti nuovi solo se venivano rimossi i limiti imposti dai suoi autori al modo in cui lo spazio-tempo può curvarsi nella dimensione aggiuntiva, ma nessuno di tali effetti trovò conferma sperimentale. La teoria venne quindi abbandonata, e riguardata al più come una intelligente curiosità matematica.

Se però ricordate quanto abbiamo detto nel § 7.9, già sapete che gli errori (o presunti tali) di una grande mente valgono più delle verità enunciate da una mente mediocre. Come la famosa costante cosmologica Λ di Einstein fu rispolverata allorché ci si avvide che l'universo sta accelerando e non rallentando, così anche la teoria di Kaluza-Klein venne riscoperta negli anni sessanta, quando si scopri che le nuove teorie di gauge che stavano destando un interesse crescente in vista della Grande Unificazione potevano essere riformulate proprio come teorie di Kaluza-Klein, nelle quali lo spazio è dotato non di una sola, ma di più dimensioni microscopiche aggiuntive, anch'esse "arrotolate" su una scala dimensionale pari a quella di Planck, e quindi invisibili ai nostri occhi, ed anche a quelli dei più potenti acceleratori di particelle. Si scoprì così che i due teorici degli anni venti avevano visto giusto, e che tutta la fisica si può tradurre in termini geometrici.

Dato che alla forza elettromagnetica e a quella gravitazionale si erano aggiunte la forza nucleare forte e la forza nucleare debole, una sola dimensione non è più sufficiente per descrivere le moderne teorie di gauge in termini di dimensioni "nascoste". Tra tutte le versioni aggiornate dell'idea originaria di Kaluza e Klein formulate dagli scienziati, quella di maggior successo è la cosiddetta supergravità, ideata nel 1973 dal sovietico Dmitriy Volkov e poi perfezionata nel 1976 da Daniel Freedman, Peter van Nieuwenhuizen e Sergio Ferrara. Questa complicatissima teoria richiede che allo spazio-tempo di Einstein siano attribuite altre sette dimensioni oltre alle quattro ordinarie. Queste sette dimensioni non possono più essere arrotolate dentro un nanocilindro, ma vengono pensate come racchiuse dentro una struttura compatta chiamata eptasfera, una ipersfera a sette dimensioni. Ad ogni evento dello spazio-tempo ordinario di Einstein (x, y, z, t) è associata una eptasfera di dimensioni paragonabili alla scala di Planck, che contiene tutte le dimensioni "impacchettate", dando alla geometria dell'universo il curioso aspetto raffigurato in questo disegno: